L’intelligence artificielle open source connaît actuellement une forte croissance. Et les entreprises IA continuent d’enrichir cette ressource avec des innovations. Cohere, une startup canadienne, est la dernière en date à y avoir contribué. Elle dévoile Aya, un modèle de langage multilingue entièrement ouvert.

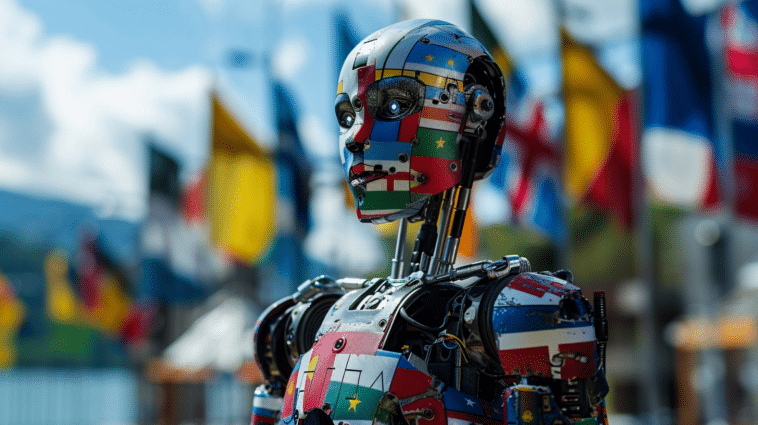

Aya, un grand modèle de langage pour le monde entier

C’est une avancée significative dans le domaine de l’IA. Pour la première fois, la communauté open source a à sa disposition un LLM massivement multilingue. Jusqu’à présent, les meilleurs modèles à accès libre existants ne couvrent pas plus de 50 langues. Par exemple, le modèle open source Bloom ne prend en charge que 46 langues.

Aya, cette nouvelle intelligence artificielle générative, peut générer des textes dans 101 langues différentes. Elle offre donc une couverture pour 50 langues supplémentaires qui n’étaient auparavant pas prises en charge. Des langues moins courantes comme l’ouzbek et le somali sont désormais incluses. La société souligne que « de nombreuses langues de cette collection n’avaient auparavant aucune représentation dans les ensembles de données de style instruction. »

Lancé en janvier 2023, ce projet est le fruit d’une collaboration internationale de 3 000 chercheurs répartis dans 119 pays. Aya est déjà disponible sur la plateforme Hugging Face.

Un modèle performant surpassant ses homologues

Les chercheurs ont affiné le LLM Aya sur une importante base de données multilingues. Par la suite, ils ont réalisé des tests comparatifs afin d’évaluer les performances de ce nouveau modèle de langage open source.

Les résultats sont concluants : cette intelligence artificielle de Cohere génère des réponses de meilleure qualité que d’autres modèles tels que mTOx et Bloom dans 77 % des cas, selon les annotateurs experts.

Une véritable mine d’or pour l’entraînement des IA multilingues

En plus du grand modèle de langage Aya, les chercheurs ont publié l’énorme jeu de données utilisé pour le projet. Cela permettra aux développeurs de créer plus facilement des modèles d’intelligence artificielle multilingues. En fait, le manque de ressources était jusqu’à présent un grand obstacle à l’entraînement des IA dans des langues moins répandues. Mais ce problème semble donc résolu. Désormais, les développeurs peuvent choisir dans ce jeu de données les langues qu’ils souhaitent itérer pour la création et la personnalisation de leur IA.

Selon Aleksa Gordic, un ancien chercheur en IA chez DeepMind, les performances des LLM dépendent fortement de la quantité et de la qualité de données d’entraînement qui leur sont fournies. Pour permettre l’émergence de modèles performants dans d’autres langues, des bases de données multilingues de grande ampleur sont indispensables. Il a salué l’initiative de Cohere qui a assemblé un tel jeu de données massif couvrant plus d’une centaine de langues.

Celui-ci est d’ailleurs le plus complet existant à ce jour, avec 513 millions d’annotations. Il constitue donc une mine d’or pour la communauté de recherche pour l’entraînement de modèles d’IA multilingues. D’après Cohere, de telles données en dehors de l’anglais sont rares et précieuses. Aya ouvre la voie à la création de modèles multilingues de qualité dans des cultures du monde entier.

- Partager l'article :