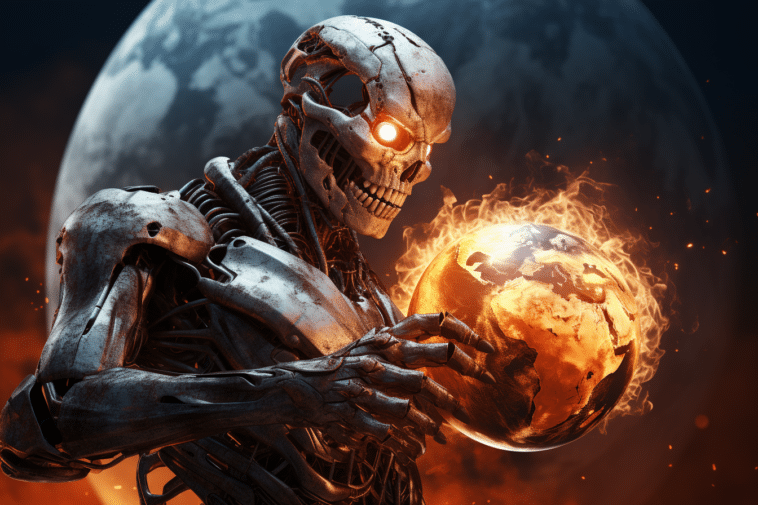

L'intelligence artificielle exige de plus en plus d'énergie ! Selon une enquête d'un Data Scientist relayée par le New York Times, elle pourrait bientôt consommer autant d'électricité qu'un pays de la taille de l'Argentine ou de la Suède. Dans ces conditions, quel avenir pour l'IA ?

Depuis leur lancement, les chatbots comme ChatGPT et Google Bard connaissent un succès retentissant. Des millions de personnes les utilisent au quotidien pour le travail, en guise d'assistant personnel ou comme alternative aux moteurs de recherche web.

De même, les générateurs d'image comme MidJourney et DALL-E 3 sont utilisés massivement pour la création artistique, le design, l'illustration, la propagande, ou tout simplement pour se divertir en créant des memes.

L'intelligence artificielle générative est désormais omniprésente, de plus en plus d'outils apparaissent, et le nombre d'utilisateurs ne cesse d'augmenter.

Mais quelles sont les limites ?

Malgré les révélations choc au cours des derniers mois, beaucoup d'utilisateurs ignorent la quantité astronomique d'eau et d'électricité consommée par cette technologie.

Pour fonctionner, ChatGPT et les autres IA reposent sur d'immenses Data Centers qui sont de véritables gouffres énergétiques.

Rien que pour son entraînement, GPT-3 a nécessité 1287 gigawatts heures. C'est l'équivalent de 100 foyers pendant une année complète. Et chacune de vos questions posées au chatbot consomme l'équivalent d'un verre d'eau !

Or, selon les dernières études, les besoins en énergie de l'IA continuent d'augmenter de façon explosive au point de dépasser l'entendement.

L'IA va bientôt consommer 0,5% de l'électricité mondiale

Selon une récente analyse du Data Scientist néerlandais Alex de Vries publiée dans le journal Joule, d'ici 2027, les fermes de serveurs pourraient utiliser entre 85 et 134 térawatts heures par an.

Cela représente l'équivalent de la consommation annuelle d'Argentine, des Pays-Bas ou de la Suède. Plus concrètement, l'IA va engloutir à elle seule 0,5% de toute l'électricité utilisée sur la planète.

Probably an underestimate. In less than ten years each American will have a dozen or more AI agents constantly running around the net with AI that is 10x more powerful. Huge increase in per capita consumption of electricity. Add the consumption of electricity by EV's and we will…

— Vinod Khosla (@vkhosla) October 11, 2023

D'ailleurs, une autre technologie a atteint un même niveau de consommation énergétique au cours des dernières années : la cryptomonnaie.

En outre, bien qu'OpenAI et les autres entreprises de l'IA tiennent secrète leur consommation, De Vries propose une estimation basée sur les ventes de GPU Nvidia A100 : une carte graphique utilisée par 95% de l'industrie. Selon lui, « chaque serveur Nvidia est une bête affamée d'énergie ».

Faut-il réduire notre utilisation de l'IA ?

Face à cette empreinte carbone colossale, les experts estiment que nous devons d'urgence reconsidérer les immenses investissements dans le domaine de l'IA voire peut-être même son utilisation…

Pour Roberto Verdecchia de l'Université de Florence, interrogé par le NYT, « peut-être que nous devons idéalement ralentir un peu l'application des solutions que nous avons ».

Il suggère par exemple de « ne pas créer un nouveau modèle pour améliorer uniquement sa vitesse et sa précision ». De plus, il appelle à « prendre une grande respiration et regarder combien nous brûlons en termes de ressources environnementales ».

Un appel qui rappelle la lettre ouverte réclamant une pause d'au moins six mois dans le développement de l'IA, signée par plus de 1000 experts en mars 2023 dont l'illustre Elon Musk. Malheureusement, cette demande n'a pas été écoutée…

La Californie peut-elle ouvrir la voie vers une IA plus verte ?

Les entreprises basées en Californie, qui représentent une grande proportion du secteur de l'IA, risquent toutefois d'être rapidement confrontées à une forte opposition dans un avenir proche.

Au cours du dernier weekend, le gouverneur Gavin Newsom a signé deux nouvelles lois pour le climat forçant les entreprises comme Google et OpenAI à indiquer le carbone qu'elles produisent d'ici 2026.

Cette nouvelle obligation concerne plus de 10 000 entreprises, et va mettre un terme à la culture du secret qui règne à l'heure actuelle dans la Silicon Valley.

Néanmoins, malgré l'œil des régulateurs, l'industrie continue essentiellement à se gouverner seule. Il est fort probable que les GAFAM et les startups continuent à brûler d'immenses volumes d'énergie au nom de la guerre de l'IA…

- Partager l'article :