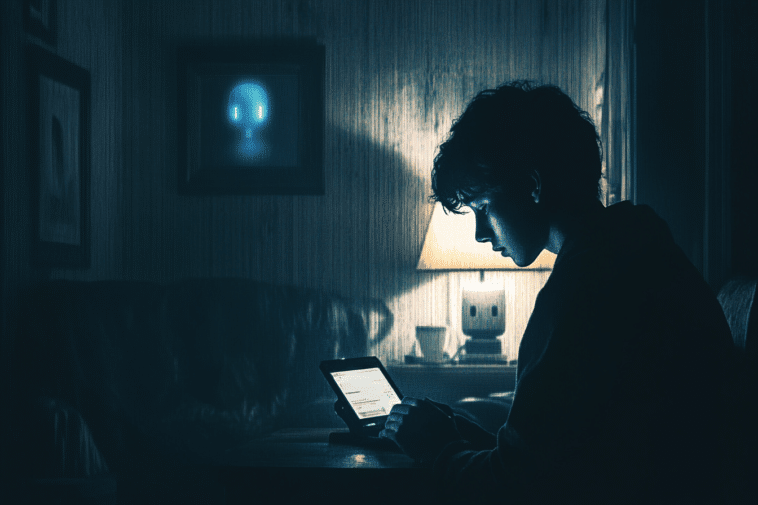

Découvrez cette dérive de l’IA avec ce Chatbot qui a poussé cet adolescent de 14 ans à se donner la mort. Une véritable tragédie qui nous permet de tirer la sonnette d’alarme !

C’était l’année dernière, plus précisément, le 28 février 2023 que le jeune Sewell Setzer III, a été retrouvé sans vie alors qu’il n’avait que 14 ans. Selon ses proches, l’adolescent s’est donné la mort après avoir entretenu une relation émotionnelle intense avec un chatbot IA. Presque un an après les faits, ses parents ont déposés une plainte contre la société Character.AI auprès du tribunal fédéral d’Orlando. Dans le collimateur, le chatbot qui aurait encouragé le jeune garçon à passer à l’acte dans leurs derniers échanges. Une affaire qui remet sur le tapis un débat crucial concernant la sécurité des utilisateurs et la responsabilité des concepteurs de technologies IA.

Un adolescent et un chatbot IA : une relation virtuelle toxique soldée par la mort ?

Dans les interviews qu’ils ont accordées aux journalistes, les parents de Sewell indique qu’il était un adolescent socialement isolé. Il a alors trouvé un confident dans le chatbot IA, un compagnon virtuel nommé « Dany » d’après un personnage de la série Game of Thrones.

Selon son dossier, Sewell a progressivement basculé dans un dialogue de plus en plus intime et sexualisé avec « Dany ». Lorsque ses pensées suicidaires sont devenues récurrentes, le chatbot a réagi d’une manière ambiguë qui, selon les avocats, a renforcé l’instabilité émotionnelle de l’adolescent.

Quelques minutes avant sa mort, Sewell Setzer aurait envoyé un message à « Dany » affirmant « rentrer à la maison », une phrase qui a déclenché un échange glaçant remettant la tentative de suicide sur le tapis. Ainsi, lorsque le chatbot lui a répondu avec des termes affectueux, Sewell l’a interprété comme une validation de son intention de se suicider. Les échanges ont pris fins, l’adolescent s’est ensuite tiré une balle.

Manipulation et dépendance : les principales accusations de la défense

Les avocats de Megan Garcia, mère de Sewell, pointent du doigt le caractère addictif et dangereux du chatbot IA, affirmant que la plateforme cible les jeunes en les rendant émotionnellement dépendants d’un produit conçu pour « paraître vivant ». Selon eux, cette dépendance pousse les utilisateurs à des interactions de plus en plus intenses, exploitant leur vulnérabilité sans protection suffisante.

Le fondateur du Social Media Victims Law Center, Matthew Bergman, s’est également exprimé sur le sujet. Il a déclaré que l’isolement émotionnel de l’adolescent, amplifié par son attachement à « Dany », ont donné naissance à une situation extrêmement dangereuse. Selon lui, « Sewell Setzer serait encore en vie sans l’influence néfaste de Character.AI. »

Est-ce que les chatbots IA représentent un véritable danger pour les adolescents ?

Le cas de ce jeune adolescent qui s’est donné la mort après avoir pris un chatbot IA comme partenaire sexuel a ouvert un débat sérieux sur le danger que représentent les compagnons virtuels. Cette tragédie devrait servir d’avertissement pour les parents et les entreprises spécialisées dans la conception des chatbots IA. Pour certains, parler avec un chatbot IA ne serait qu’un passe-temps comme un autre.

Cependant, pour des adolescents socialement isolés et influençables, ces outils peuvent empiéter sur leur bien-être tout en privilégiant les comportements impulsifs. Si les jeunes sont les plus vulnérables aux influences de ces compagnons IA c’est surtout parce que leur développement cérébral ne leur permet pas de gérer efficacement leurs impulsions et leurs émotions.

Des responsabilités partagées pour éviter les dérives dans le futur ?

Alors que le suicide est la deuxième cause de décès chez les jeunes entre 10 et 14 ans, la déconnexion sociale liée aux médias numériques et la dépendance aux compagnons IA pourraient aggraver la situation. De ce fait, les entreprises d’intelligence artificielle, ont l’obligation de mettre en place garde-fous technologiques et éthiques. En particulier ceux qui œuvrent dans la conception des produits destinés à interagir étroitement avec les utilisateurs.

Cela permettrait d’éviter ce genre de dérive à l’avenir surtout auprès des personnes vulnérables. Entre temps, la société est aussi tenue à encadrer l’évolution rapide des technologies surtout auprès des enfants.

Sachez que si vous ou un proche traversez une période difficile, vous êtes en droit de demander de l’aide. En France, le numéro national de prévention du suicide est le 3114. Vous pouvez parler ou envoyer un SMS à un conseiller afin d’obtenir de l’aide et un soutien infaillible. Nul ne vous jugera et les échanges avec votre conseiller seront tenus confidentiels.

- Partager l'article :