ChatGPT, Gemini, Claude, Sora, Dream Machine, Kling, Suno AI, et tout autres systèmes d’IA sont aujourd’hui à la version la plus récente et la plus performante. Mais l’entraînement des modèles qui alimentent ces IA génératives nécessite un important volume de données. Pour le cas de Grok par exemple, X a été poursuivi en justice en raison d’une utilisation illégale des données de ses utilisateurs. À ce stade, les informations sensibles sont déjà en danger.

Or, on ne sait pas encore à quel niveau de performance ces IA sont dangereuses. Ni même à quel point elles présentent un risque pour la sécurité des utilisateurs.

En ce qui concerne l’Union européenne, elle a mis en place une mesure législative qui va cadrer l’utilisation de l’intelligence artificielle. Mais dans la majorité des cas, les garde-fous semblent encore assez flous.

Meta, Google, Anthropic et OpenAI dans la ligne de mire des autorités

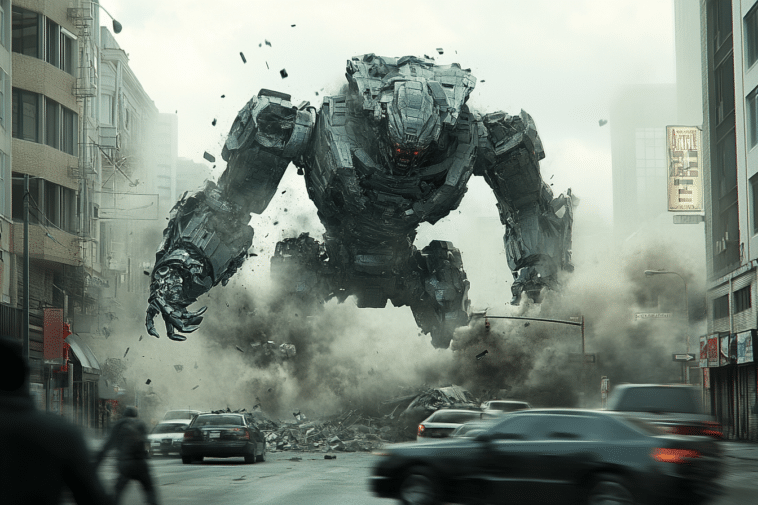

Certains décideurs politiques et experts en sécurité de l’IA s’inquiètent davantage du potentiel destructeur que pourrait avoir cette technologie à l’avenir.

Ils craignent notamment que sa puissance de calcul croissante puisse être détournée pour concevoir des armes extrêmement dangereuses. Ou encore pour orchestrer des attaques informatiques d’une ampleur sans précédent.

Face à ces préoccupations, des législations actuellement sont en cours d’élaboration. Leur objectif est d’établir une distinction claire entre les IA génératives actuelles et les futurs systèmes, potentiellement bien plus puissants.

Dans cette optique, les autorités de régulation gardent un œil attentif sur les géants du secteur tels qu’Anthropic, Google, Meta et OpenAI.

De nouvelles régulations du côté américain

Aux États-Unis, le président Biden a récemment signé un décret établissant des seuils de puissance pour l’IA.

La Californie a emboîté le pas avec une proposition de loi sur la sécurité de l’IA, dont le sort sera scellé d’ici la fin de ce mois.

Mais cette législation californienne ajoute une clause financière : tout modèle réglementé devra avoir nécessité un investissement d’au moins 100 millions de dollars pour son développement.

De son côté, l’Union européenne a fixé sa propre limite de calcul. C’est-à-dire dix fois inférieure à celle des États-Unis, ce qui englobe déjà certains systèmes existants.

À l’heure actuelle, aucun modèle accessible au public ne dépasse le seuil californien. Mais il est tout à fait possible que des start-ups travaillent déjà sur de tels systèmes.

Alors, pour anticiper cette éventualité, l’administration Biden exige, en vertu d’une loi datant de la guerre de Corée, que les entreprises informent le ministère du Commerce si elles développent des modèles d’une telle puissance.

Les experts et les investisseurs aussi ont leur mot à dire

Quoi qu’il en soit, les réglementations actuelles sur l’IA font l’objet de critiques de la part de certains experts du domaine. Ils estiment en effet que ces mesures sont trop simplistes pour être réellement efficaces.

Un spécialiste de chez Cohere, Sara Hooker, fait partie de ceux qui remettent en question la pertinence scientifique de ces seuils comme indicateurs fiables du risque de l’IA.

Selon elle, il n’existe pas de base scientifique solide pour justifier l’utilisation de ces critères.

Du côté des investisseurs, Marc Andreessen et Ben Horowitz, deux capital-risqueurs renommés, expriment également leur désaccord avec ces réglementations.

Ils craignent que ces mesures ne freinent l’innovation, particulièrement dans le secteur des start-ups spécialisées en IA.

Quant à Horowitz, il a notamment soulevé une question provocante lors d’une émission de podcast.

Il suggère que ces limitations pourraient entraver des avancées majeures, comme la découverte d’un traitement contre le cancer.

D’autres tests à prévoir ?

En tout cas, le débat reste ouvert en ce qui concerne à la meilleure façon d’évaluer les capacités des IA génératives les plus récentes.

D’autres tests sont actuellement en cours de réalisation. Et ce sont des examens qui ont pour objectif de mesurer la capacité à résoudre des problèmes complexes, le raisonnement logique, ou encore la précision des réponses fournies par les chatbots.

Mais aucun ne semble offrir une mesure claire et définitive du danger que ces technologies pourraient représenter pour l’humanité.

En somme, il ne faut se fier aux benchmarks pour calculer la vraie puissance des modèles d’IA.

- Partager l'article :