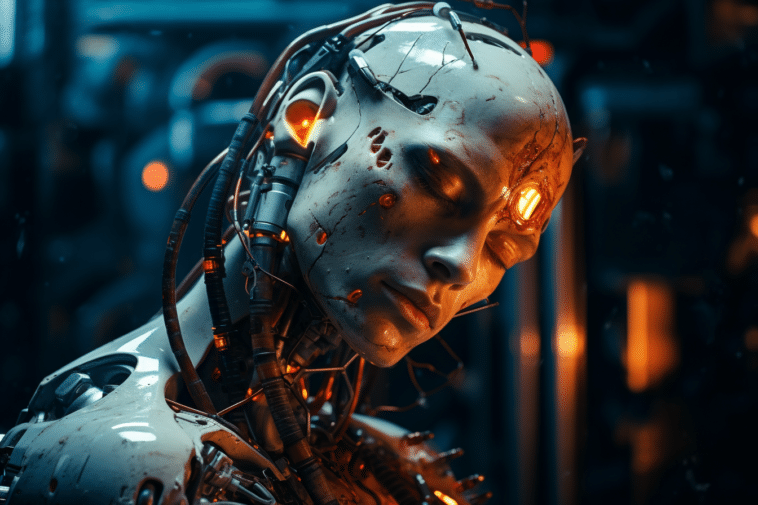

Alors que la technologie des grands modèles de langage avance à pas de géant, la question se pose : ces systèmes sont-ils véritablement conscients ? Une enquête approfondie sur la nature de la conscience de l'IA pour le futur.

La conscience a toujours été l'apanage des êtres vivants, mais à l'ère de l'intelligence artificielle, cette affirmation est mise à l'épreuve. En 2022, Blake Lemoine de Google a ébruité que leur chatbot LaMDA, désormais appelé Bard, possédait une conscience semblable à celle d'un enfant de sept ans. Alimenté par un grand modèle de langage similaire au GPT d'OpenAI, ce développement a soulevé des interrogations profondes sur la nature de la conscience dans les systèmes d'IA.

La conscience de l'IA dans les cas de LaMDA et GPT

LaMDA, rebaptisé Bard, est propulsé par un grand modèle de langage LLM, similaire à GPT-3. Bien que des millions aient interagi avec ces LLM, la majorité les perçoit comme de simples « perroquets stochastiques ». Nombreux sont ainsi ceux qui pensent qu'ils sont capables de tenir une conversation sans en comprendre le sens, comme le décrit si bien la linguiste Emily Bender.

Des chercheurs, alliant philosophie, neurosciences et informatique, se sont penchés sur les caractéristiques que devrait avoir un système véritablement conscient. Leurs conclusions sont claires : aucune technologie actuelle n'est vraiment consciente. Mais rien n'indique qu'il en sera toujours ainsi à l'avenir.

La quête des indicateurs de conscience

Depuis Alan Turing et son « Jeu d'imitation », l'aptitude à imiter la conversation humaine est souvent vue comme un signe de conscience. Cependant, avec les prouesses conversationnelles des LLM, cette perspective pourrait changer. Pour aborder la conscience de l'IA sous un nouveau jour, ces chercheurs ont établi une liste de « propriétés indicatrices » basée sur les théories actuelles de la conscience humaine.

Les indicateurs recherchés s'éloignent des performances conversationnelles et se concentrent sur les processus informatiques qui, dans le cerveau humain, semblent soutenir la conscience. Les théories diffèrent, mais toutes fournissent des éléments précieux pour créer une liste d'indicateurs.

ChatGPT est-il conscient ou non ?

Selon les critères établis, il n'y a aucune raison de croire que les systèmes d'IA actuels, y compris ChatGPT, possèdent une conscience. Les architectures actuelles satisfont à quelques indicateurs, mais pas à la majorité.

Tout comme nous sommes toujours en train d'apprendre sur la conscience dans le règne animal, l'IA pose des questions similaires. Si nous parvenons un jour à créer une IA consciente, il nous faudra réfléchir sérieusement à ses droits et à ses implications éthiques.

La question de la conscience en IA ne se limite pas à savoir si ces systèmes peuvent parler ou penser comme nous, mais à comprendre les mécanismes profonds qui sous-tendent la conscience. Si la technologie actuelle n'est pas encore à ce niveau, le futur reste ouvert à toutes les possibilités.

- Partager l'article :