Avec son nouveau service Singularity, Microsoft vise à réduire le coût et les efforts inutiles liés à l’intelligence artificielle.

Avec les progrès en termes de machine learning et de deep learning, les charges de travail de l’IA demandent de plus en plus de puissance. Les grandes entreprises technologiques s’appliquent actuellement à rendre le supercalcul plus accessible, autant en interne que pour les clients.

Singularity, la nouvelle infrastructure d’IA de Microsoft

Dans un article intitulé « Singularity: Planet-Scale, Preemptive and Elastic Scheduling of AI Workloads », les équipes de Microsoft Research et de Microsoft Azure ont présenté leur nouvelle infrastructure d’IA, Singularity. Il s’agit d’un service de cloud distribué qui consiste à fournir aux professionnels de l’IA un moyen de construire, de mettre à l’échelle et d’expérimenter leurs modèles.

Comme principal objectif, les auteurs du document citent la réduction du coût de l’IA. Entre autres, Singularity vise à maximiser le débit de l’ensemble d’une flotte à l’échelle mondiale. Pour y parvenir, le service traite l’ensemble de la flotte d’accélérateurs comme un seul cluster. Cela permet d’éviter les immobilisations des ressources.

Avec Singularity, Microsoft souhaite également fournir des SLA au niveau des tâches. Par ailleurs, il offre une résilience aux défaillances. En termes simples, cela permet de reprendre les tâches là où elles ont été interrompues au lieu de tout recommencer. Ainsi, il minimise les efforts inutiles lors de la formation des réseaux neuronaux profonds qui prennent beaucoup de temps.

Un nom familier ?

Singularity, le nom de code choisi par les équipes de Microsoft Azure et Research pourrait être familier pour certains. En effet, entre 2003 et 2015, Microsoft Research a développé un projet du même nom. Il s’agissait d’un système d’exploitation à micro-noyau incluant des outils et des bibliothèques en code géré. Le système Singularity a influencé plusieurs projets tels que Barrelfish, Helios, Midori et Drawbridge.

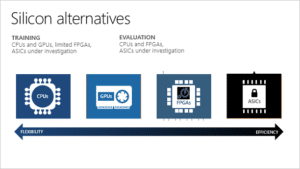

Quant à la nouvelle infrastructure d’IA développée actuellement, les chercheurs la présentent comme un nouveau « planificateur qui tient compte de la charge de travail ». Il permettra donc d’optimiser les charges de travail de deep learning sur une flotte mondiale de GPU ou de FPGA, sans affecter leurs performances.

Rappelons que Microsoft a récemment évoqué la mise à disponision des FPGA en tant que service pour les clients. Et en novembre dernier, la compagnie a annoncé l’intégration des GPU NVIDIA A100 de 80 Go dans sa gamme de supercalculateurs.

- Partager l'article :