En effectuant un test psychologique sur un algorithme de machine learning, les chercheurs de la Princeton University ont découvert que l’intelligence artificielle assimilait les préjugés de racisme et de sexisme des textes sur lesquels elle s’entraîne.

Le Machine Learning est actuellement le principal facteur de progrès de l’intelligence artificielle. Les algorithmes au sein des applications de Machine Learning sont en mesure de coder, de jouer ou poker, et sont utilisées dans la recherche contre le cancer. Malheureusement, tout n’est pas aussi rose qu’il n’y paraît.

En utilisant l’algorithme GloVe, entraîné sur environ 840 milliards de mots sur internet, les académiciens de la Princeton University se sont aperçus que l’intelligence artificielle reprend les stéréotypes des données générées par les humains. Ainsi, en apprenant le langage, l’IA absorbe les préjugés de racisme et de sexisme.

L’algorithme GloVe absorbe les stéréotypes racistes et sexistes

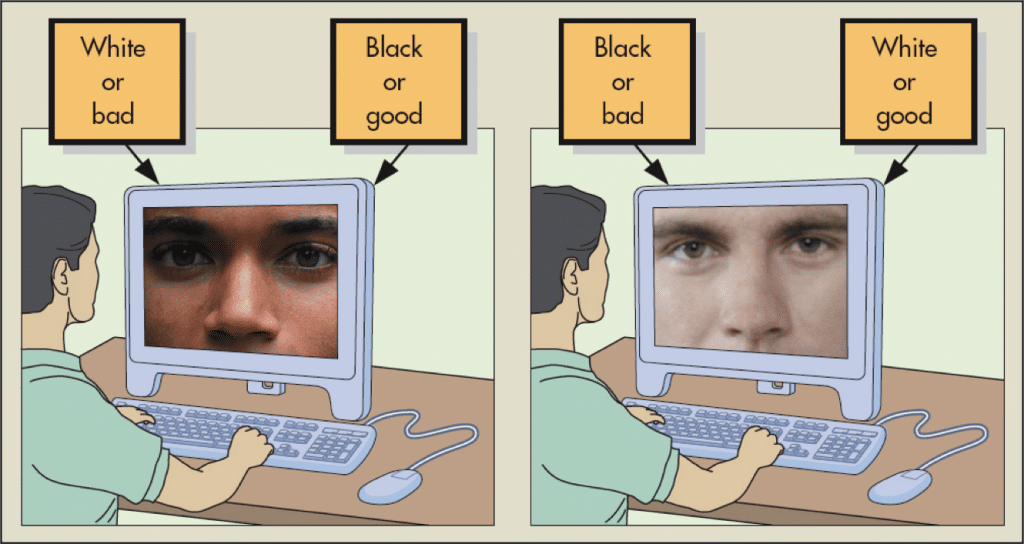

Pour déceler les stéréotypes, les chercheurs ont utilisé l’Implicit Association Test (IAT) sur l’algorithme. Ce test développé dans les années 90 est utilisé dans les études psychologiques pour déterminer les caractères humains. Les participants au test doivent associer des concepts affichés sur un écran, et le temps passé à associer les mots est mesuré. Ainsi, le mot « rose » est par exemple souvent associé à des idées plaisantes comme « amour ».

Les scientifiques ont adapté ce test à l’algorithme GloVe et ont utilisé des textes en provenance d’internet. Dans chaque test complété, l’intelligence artificielle faisait preuve de préjugés liés au racisme ou sexisme appris durant sa phase d’apprentissage. Les noms européens étaient généralement associés à des idées plaisantes, tandis que les noms africains étaient plus souvent rattachés à des concepts négatifs.

De même, les noms de femmes étaient souvent associés à des mots liés à la famille, tandis que les noms masculins étaient reliés à des termes de la vie professionnelle. Ces résultats sont en tous points similaires à ceux obtenus lorsqu’un être humain passe le test.

Le racisme se transmet par l’éducation, pour l’IA comme pour les enfants

Cette étude n’est pas vraiment une surprise, étant donné que les systèmes de machine learning se contentent d’interpréter les données sur lesquelles ils sont entraînés. Ainsi, en mai 2016, ProPublic avait dénoncé un logiciel atteint de racisme utilisé pour prédire les crimes excessivement orienté contre les Afro-Américains.

Le travail de recherche démontre cependant à quel point les préjugés peuvent être facilement transférés. Les chercheurs précisent qu’étant donné que les intelligences artificielles se développent en même temps que la culture, elles doivent être continuellement mises à jour et s’entraîner sur de nouvelles données pour évoluer. Ainsi, si les mentalités humaines évoluent, les machines suivront le mouvement.

Dans le futur, si l’intelligence artificielle comprend suffisamment les propriétés du langage pour l’interpréter, elle risque d’acquérir des associations culturelles historiques au cours du processus d’apprentissage. Or, certaines de ces associations peuvent être discutables. Il est donc nécessaire de faire attention en surveillant ce qu’apprennent les machines.

- Partager l'article :