Google DeepMind innove en enseignant aux robots des tâches complexes grâce à l’observation humaine. Nouer des lacets, accrocher des vêtements, ou réparer d’autres robots deviennent possibles. Cette avancée marque une étape vers des robots plus autonomes, adroits et intégrés dans la vie quotidienne.

Les robots imitent les humains pour maîtriser des tâches complexes

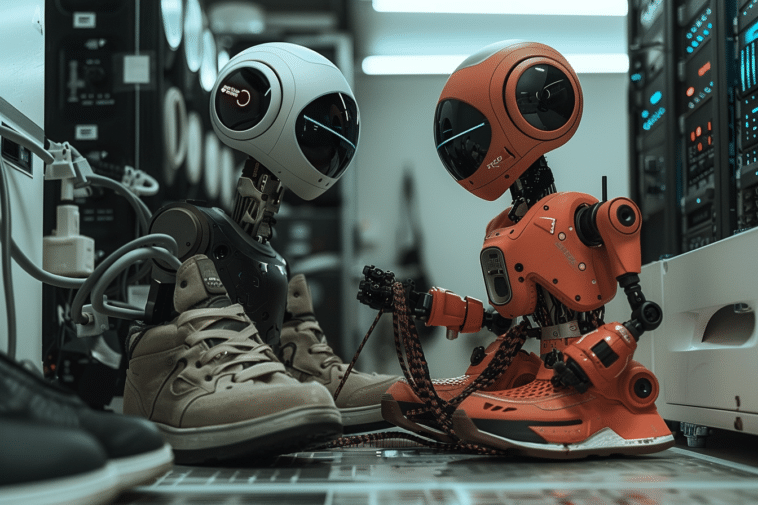

Google DeepMind repousse les limites de l’intelligence artificielle. Grâce à sa nouvelle plateforme ALOHA Unleashed, les robots apprennent à imiter les gestes humains. Nouer des lacets, accrocher une chemise et même réparer d’autres robots, voilà désormais à leur portée. Ce système, combiné avec DemoStart, leur permet d’observer les humains pour reproduire des actions complexes. De plus, cette avancée ouvre des perspectives pour des applications variées, y compris dans le domaine de l’accessibilité. Effectivement, des personnes en situation de handicap pourraient bénéficier de cette technologie. Ainsi, les robots deviendraient des assistants plus adroits et polyvalents dans la vie quotidienne.

Le programme développé par DeepMind démontre la capacité des robots à s’adapter. Ces derniers apprennent par des démonstrations visuelles et, par conséquent, gagnent en dextérité. L’apprentissage autonome de ces dispositifs marque un tournant majeur dans leur évolution. En imitant des actions humaines, ils améliorent non seulement leur précision, mais aussi leur polyvalence. Cette méthode pourrait, par exemple, s’appliquer à d’autres domaines nécessitant des gestes précis. Les chercheurs explorent déjà ces pistes et espèrent transformer la robotique en un atout accessible à tous.

Un pas de plus vers des robots autonomes et utiles au quotidien

L’ambition de Google DeepMind va au-delà des démonstrations spectaculaires. Le but est de rendre les robots véritablement utiles au quotidien, en leur apprenant à effectuer des tâches complexes. Par ailleurs, l’apprentissage autonome leur permet de s’adapter à des environnements variés. Cela inclut non seulement des tâches domestiques, mais aussi des applications industrielles et médicales. Cette avancée pourrait révolutionner la manière dont ces appareils interagissent avec les humains et les objets autour d’eux. De plus, ces dispositifs pourraient devenir des aides précieuses pour les personnes âgées ou en situation de handicap.

Google DeepMind vise à combiner l’apprentissage visuel avec des algorithmes avancés. Cela permet aux robots de développer des compétences à partir d’exemples concrets. Ils n’ont plus seulement besoin de lignes de code pour comprendre une tâche, mais ils apprennent en observant des humains. Ces dispositifs deviennent donc plus intelligents et adaptatifs. Cela contribue d’ailleurs à réduire le fossé entre les capacités humaines et robotiques. Ce type d’apprentissage pourrait même ouvrir la voie à des collaborations inédites entre humains et machines.

Les défis à surmonter pour une intégration parfaite des robots

Cependant, il reste des défis à surmonter pour intégrer pleinement les robots dans la vie quotidienne. La complexité des tâches humaines pose encore problème aux systèmes robotiques. Les chercheurs doivent donc affiner les algorithmes pour permettre une adaptation rapide et efficace. L’un des principaux obstacles réside dans la diversité des environnements. Chaque maison, chaque espace de travail présente des particularités que les robots doivent apprendre à gérer. Google DeepMind continue donc d’améliorer ses modèles pour surmonter ces obstacles.

Les implications éthiques et sécuritaires de ces technologies sont également en débat. Les chercheurs et ingénieurs doivent garantir que les robots restent sous contrôle humain et agissent de manière sûre. La question de la confidentialité et de l’utilisation des données récoltées par les machines est cruciale. Les régulations devront s’adapter pour encadrer l’évolution rapide de cette technologie. Malgré ces défis, le potentiel des robots autonomes est immense et prometteur pour un futur où ils seront de véritables alliés au quotidien.

- Partager l'article :