Le test de Turing est un test permettant de vérifier la capacité d’une machine à faire preuve de signes d’intelligence humaine. Encore aujourd’hui, ce test fait figure de standard pour déterminer l’intelligence d’une machine, en dépit de nombreuses critiques formulées au fil des années.

Le principe du Test de Turing reste fondamentalement simple, mais mérite une mise à jour à mesure que la technologie et les discussions autour de l’intelligence artificielle évoluent. Ce test consiste toujours en une évaluation humaine de la capacité d’une machine à imiter le comportement humain lors d’une conversation textuelle. L’évaluateur humain, qui sait qu’un des deux participants est une machine, doit déterminer lequel est l’humain. S’il n’est pas en mesure de discerner l’homme de la machine après 5 minutes de conversation, la machine a passé le test avec succès.

Alan Turing, le créateur du test de Turing

Ce test a été conçu par Alan Turing, mathématicien et professeur à l’Université de Manchester, en 1950. Il a été présenté pour la première fois dans l’article historique intitulé « Computing Machinery and Intelligence », qui se concentrait sur la question clé : « Les machines peuvent-elles penser ? ». Ce texte fondateur explore la possibilité d’une intelligence artificielle en proposant un test pratique pour déterminer si une machine peut imiter un comportement humain de manière convaincante.

Dès les années 1940, Turing a réfléchi à la question de l’intelligence des machines, notamment dans son rapport de 1947 intitulé « Intelligent Machinery », où il pose les bases du concept. Dans ce rapport, Turing explore les possibilités de créer des machines capables d’adopter des comportements intelligents, préfigurant ainsi le célèbre Test de Turing.

L’article de 1950 marque un tournant, introduisant l’idée de l’« Imitation Game », où un juge interagit avec un humain et une machine via des échanges textuels. Si le juge est incapable de distinguer l’humain de la machine, cette dernière est considérée comme ayant « réussi » le test. Cette première version du test a évolué au fil des années. En 1952, une nouvelle itération consistait à ce que la machine persuade un jury qu’elle est humaine, une méthode qui est devenue la version la plus couramment utilisée aujourd’hui dans les évaluations d’intelligence artificielle.

ELIZA et PARRY : les deux premiers programmes capables de passer le Test de Turing

ELIZA et PARRY sont les premiers programmes à avoir réussi à tromper des humains lors de conversations simulées, relevant ainsi d’une forme primitive du Test de Turing. En 1966, Joseph Weizenbaum développa ELIZA, un programme qui simule une conversation humaine à travers des échanges textuels. ELIZA fonctionne en analysant un texte à la recherche de mots-clés pour générer des réponses adaptées. Lorsqu’aucun mot-clé pertinent n’est détecté, le programme produit des réponses génériques, imitant ainsi un dialogue psychothérapeutique basé sur la méthode de Carl Rogers.

Le rôle d’ELIZA était de créer l’illusion d’une compréhension humaine, bien que le programme n’ait aucune réelle compréhension du contenu des échanges. Ce stratagème permit à ELIZA de convaincre de nombreuses personnes qu’elles conversaient avec un véritable humain, faisant de lui l’un des premiers programmes à « passer » une version primitive du Test de Turing.

En 1966, Joseph Weizenbaum développa ELIZA, un programme qui simule une conversation humaine à travers des échanges textuels. ELIZA fonctionne en analysant un texte à la recherche de mots-clés pour générer des réponses adaptées. Lorsqu’aucun mot-clé pertinent n’est détecté, le programme produit des réponses génériques, imitant ainsi un dialogue psychothérapeutique basé sur la méthode de Carl Rogers. Le rôle d’ELIZA était de créer l’illusion d’une compréhension humaine, bien que le programme n’ait aucune réelle compréhension du contenu des échanges. Ce stratagème permit à ELIZA de convaincre de nombreuses personnes qu’elles conversaient avec un véritable humain, faisant de lui l’un des premiers programmes à « passer » une version primitive du Test de Turing.

Les risques liés aux chatbots modernes

Les chatbots modernes, descendants d’ELIZA et PARRY, continuent à évoluer et peuvent parfois tromper les humains de manière encore plus sophistiquée. Ces technologies sont désormais utilisées à des fins malveillantes dans certains cas. Par exemple, le malware CyberLover utilise des tactiques d’ingénierie sociale pour convaincre les utilisateurs de divulguer des informations personnelles sensibles, souvent dans un contexte de séduction en ligne. Ce type de programme montre comment les chatbots peuvent être exploités à des fins criminelles, soulignant les risques associés à ces technologies.

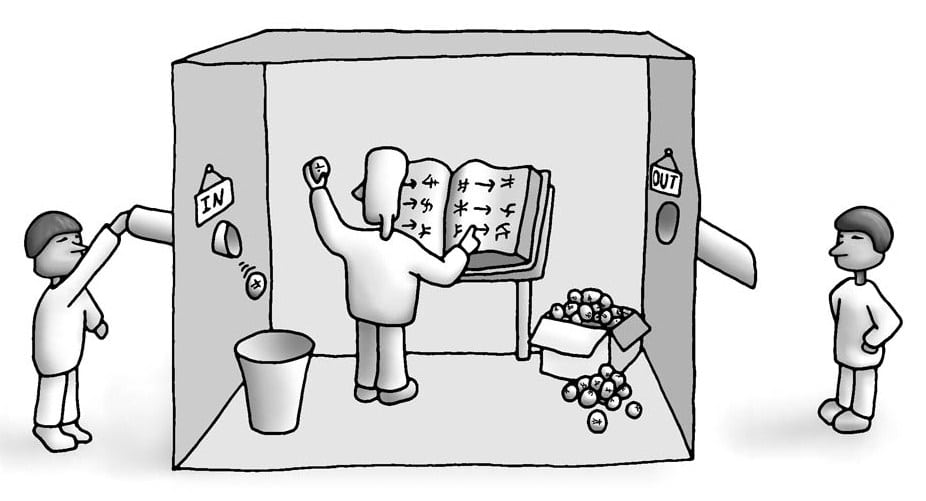

Le contre-argument de la chambre chinoise

Le contre-argument de la chambre chinoise, proposé par le philosophe John Searle en 1980, critique le Test de Turing comme une mesure valide de l’intelligence des machines. Dans son article Minds, Brains, and Programs, Searle soutient que des programmes comme ELIZA ne « pensent » pas vraiment. Son argument repose sur l’analogie de la chambre chinoise. En fait, une personne qui ne comprend pas le chinois peut suivre un ensemble de règles pour produire des réponses correctes, sans réellement comprendre le sens des symboles. De même, une machine pourrait imiter une conversation humaine sans posséder une intelligence ou une compréhension réelle.

Cet argument a conduit à un débat philosophique sur la différence entre simuler l’intelligence et comprendre réellement. Searle souligne que la manipulation de symboles ne suffit pas à prouver l’intelligence, et donc que les machines qui passent le Test de Turing ne font que simuler la pensée humaine. Ce débat, qui touche à la nature de la conscience et de la cognition, reste central dans les discussions sur l’intelligence artificielle, particulièrement face aux avancées récentes dans ce domaine.

Le Prix Loebner, grande compétition des chatbots

Le Prix Loebner, créé en 1991 par Hugh Loebner, est une compétition annuelle d’intelligence artificielle. Son objectif est de mesurer la capacité des chatbots à réussir une version du Test de Turing, en imitant une conversation humaine de manière convaincante. Cette compétition a joué un rôle important dans le développement de l’IA conversationnelle. Toutefois elle a aussi soulevé des critiques sur la validité du Test de Turing, qui favorise l’imitation humaine plutôt que l’intelligence réelle.

Les premières éditions et critiques

De 1991 à 2003, la compétition a été organisée par le Cambridge Center for Behavioral Studies. Les premières éditions ont vu des chatbots tromper des interrogateurs humains en imitant des comportements humains comme les fautes de frappe. Cependant, cela a révélé les limites du Test de Turing, certains critiques affirmant qu’il encourage la simulation plutôt que l’intelligence véritable.

Les victoires marquantes

Des programmes comme A.L.I.C.E. (Artificial Linguistic Internet Computer Entity) et Jabberwacky ont remporté plusieurs fois la médaille de bronze, qui est attribuée au chatbot ayant le comportement conversationnel le plus proche d’un humain. Cependant, les médailles d’argent et d’or, basées sur des interactions plus complexes, n’ont jamais été décernées.

En 2014, pour célébrer les 60 ans de la mort d’Alan Turing, le chatbot russe Eugene Goostman a marqué l’histoire en convainquant 33% des juges qu’il était humain lors d’une compétition à la Royal Society London. Bien que cette victoire ait été saluée, elle a aussi été critiquée pour la durée limitée des conversations et la présentation particulière du chatbot.

Le test de Turing vise à répondre à une question philosophique profonde

La question de savoir si une machine est capable de penser tourmente les philosophes depuis des centaines, voire des milliers d’années, et se posait déjà de façon sous-jacente avant même l’invention de la robotique. Cette question est au cœur de la distinction entre le dualisme et le matérialisme de l’esprit humain?

En effet, dès 1637, dans le Discours de la Méthode, René Descartes s’interroge sur des problématiques similaires. Le philosophe pointe du doigt la capacité des automates à réagir aux interactions humaines, mais souligne également leur incapacité à répondre aux paroles prononcées en leur présence de la même manière qu’un humain. C’est pour lui la principale différence entre l’Homme et la machine. Cependant, Descartes ignorait que les automates du futur dépasseraient cette barrière. De fait, il se contente de préfigurer le cadre conceptuel du Test de Turing.

Dans Pensées philosophiques, Denis Diderot quant à lui évoque les mêmes critères d’intelligence que le test de Turing. Il affirme que si un perroquet est capable de répondre à toutes les questions, ce volatile pourra sans hésitation être considéré comme intelligent. La capacité à converser était donc déjà considérée comme une preuve d’intelligence par les matérialistes.

Selon les dualistes, l’esprit n’est pas physique et ne peut donc pas être expliqué en termes purement physiques. Pour les matérialistes, l’esprit peut être expliqué physiquement, et il est donc possible de produire des esprits de manière artificielle.

En 1936, le philosophe Alfred Ayer s’est demandé comment peut-on savoir que les autres humains ont la même conscience que soi-même. Dans son livre Language, Truth and Logic, Ayer suggère un protocole pour distinguer un humain conscient d’une machine inconsciente. Selon lui, la seule façon de procéder est d’utiliser un test empirique pour déterminer la présence ou l’absence de conscience.

Forces et faiblesses du Test de Turing

Les forces du Test de Turing

L’une des principales forces du Test de Turing réside dans sa simplicité. Depuis des siècles, les philosophes, scientifiques et psychologues n’ont jamais réussi à définir précisément ce qu’est l’intelligence ou la pensée. Ce test, malgré ses limitations, a au moins l’avantage d’offrir un cadre pragmatique pour mesurer l’intelligence artificielle en se basant sur une interaction textuelle humaine.

Un autre atout est que le Test de Turing permet d’évaluer différentes compétences d’une IA, comme la maîtrise du langage naturel, la capacité de raisonnement, ainsi que l’apprentissage. En s’appuyant sur une conversation, le test ne se concentre pas uniquement sur des tâches techniques ou des calculs complexes, mais évalue la manière dont l’IA interagit émotionnellement et socialement, ce qui reflète la complexité des échanges humains.

De plus, ce test peut être adapté pour intégrer des technologies plus récentes, telles que la vision par ordinateur et d’autres formes d’interactions multimodales (texte, vidéo, audio). Cela permet d’explorer des champs plus larges dans l’évaluation de l’intelligence des machines, au-delà de la simple imitation linguistique..

Les faiblesses du test de Turing

Cependant, le Test de Turing a été critiqué à plusieurs reprises. L’une des principales critiques est qu’il n’évalue pas directement l’intelligence réelle d’une machine, mais uniquement sa capacité à simuler un comportement humain. Le fait qu’une IA puisse tromper un interlocuteur ne signifie pas nécessairement qu’elle comprend ce qu’elle dit. Par exemple, un programme pourrait imiter des comportements humains sans véritablement « penser », ce qui constitue un écart significatif entre la simulation d’une intelligence et l’intelligence elle-même.

Le jugement des interrogateurs est également remis en cause, car la qualité des interactions peut varier selon l’expertise ou les attentes de l’interrogateur. Des chatbots primitifs comme ELIZA ont montré que des réponses simples, mais convaincantes, peuvent souvent tromper des humains naïfs.

En outre, le test est limité par le fait qu’il valorise la simulation humaine plutôt que la démonstration de capacités supérieures ou non humaines. Par exemple, une machine capable de résoudre des problèmes complexes pourrait échouer au test si ses réponses sont jugées trop « non humaines », malgré sa supériorité en matière de traitement de l’information. Cela a conduit à la proposition d’alternatives pour évaluer la « super-intelligence », au lieu de se concentrer uniquement sur la simulation humaine.

Test de Turing évalue uniquement la façon dont la machine se comporte

Le Test de Turing se concentre sur la capacité d’une machine à simuler un comportement humain au cours d’une conversation textuelle, sans nécessairement comprendre la conversation elle-même. Comme l’a montré le programme ELIZA dans les années 1960, une machine peut passer le test en fournissant des réponses cohérentes, mais sans véritable compréhension. Cette simulation de l’intelligence est ce que John Searle critique dans son célèbre argument de la chambre chinoise, affirmant que le test ne vérifie pas si une machine pense réellement, mais uniquement si elle semble penser.

Turing, cependant, estimait que la question de savoir si une machine peut penser importe moins que sa capacité à se comporter comme si elle pensait. Pour lui, si une machine peut imiter un comportement humain au point de tromper un interlocuteur, elle mérite d’être considérée comme intelligente, au moins à un certain niveau. Il voyait cela comme un premier pas dans l’exploration de la conscience machine, même si cela ne permet pas d’en élucider tous les mystères..

Un autre problème souligné par Michael Shermer est celui de l’anthropomorphisme. Les humains ont tendance à attribuer des caractéristiques humaines à des objets inanimés ou non humains. Cela peut fausser le jugement lors de tests comme celui de Turing, où les interrogateurs interprètent certains comportements robotiques comme étant humains. Paradoxalement, il arrive également que des interrogateurs prennent les humains pour des machines, ce qui illustre les difficultés du test à évaluer correctement l’intelligence.

Test de Turing : les utilisations actuellement

Le Test de Turing, bien qu’ayant évolué avec le temps, reste un outil de référence dans l’évaluation de l’intelligence artificielle. Voici quelques-unes des principales applications et exemples récents.

Le Prix Loebner : une version moderne du Test de Turing

Depuis 1991, le Prix Loebner est une compétition annuelle qui récompense les chatbots capables de démontrer un comportement conversationnel proche de celui des humains. Ce concours, basé sur une version simplifiée du Test de Turing, a permis de faire progresser la recherche dans le domaine de l’IA conversationnelle. Cependant, aucun chatbot n’a encore remporté la médaille d’argent ou d’or, qui nécessitent une imitation plus complète des capacités humaines.

Eugene Goostman et les controverses du test

En 2014, le chatbot russe Eugene Goostman a fait les gros titres en réussissant à tromper 33 % des juges lors d’une compétition organisée à la Reading University, les convainquant qu’il était humain. Malgré cette performance, la victoire reste controversée. En effet, le test a duré seulement 5 minutes, et Eugene incarnait un adolescent de 13 ans, ce qui a pu excuser certaines incohérences dans ses réponses.

Google Duplex : une réussite moderne

En 2018, le service Google Duplex a marqué une étape majeure en IA. Capable de passer des appels téléphoniques pour réserver des rendez-vous, Duplex a bluffé un coiffeur qui ne se doutait pas qu’il parlait à une machine. Cet exploit a été salué comme une nouvelle avancée dans le domaine de l’IA, même si cette interaction ne correspondait pas exactement au format du Test de Turing original.

GPT-3 : des avancées majeures, mais encore des défis

GPT-3, lancé en 2020, est l’un des systèmes d’IA les plus avancés en matière de génération de texte. Doté de capacités impressionnantes, il a été considéré par certains comme une technologie capable de passer le Test de Turing. Cependant, malgré ses compétences en génération de texte, il a encore des lacunes, en particulier lorsqu’il s’agit de questions absurdes ou ambiguës, montrant ainsi que la compréhension réelle du langage reste limitée.

CAPTCHA : Un Test de Turing inversé

Le CAPTCHA (Completely Automated Public Turing test to tell Computers and Humans Apart) est une version inversée du Test de Turing. Il permet de distinguer les humains des machines en demandant aux utilisateurs de résoudre des tâches simples, comme identifier des lettres déformées ou des images spécifiques. Depuis l’avènement de l’apprentissage automatique, de nouvelles variantes de CAPTCHA, comme le reCAPTCHA, se concentrent sur des tâches plus complexes pour contrer les robots sophistiqués.

Les IA modernes face au Test de Turing

Les IA modernes, telles que GPT-4 d’OpenAI et LaMDA de Google, repoussent les limites de l’intelligence artificielle en matière de compréhension du langage naturel et d’interaction conversationnelle. Ces modèles avancés peuvent générer des réponses crédibles et cohérentes dans divers contextes, simulant ainsi des conversations proches de celles d’un humain. Cependant, malgré leurs prouesses, ces IA rencontrent encore des difficultés à passer entièrement le Test de Turing.

L’un des principaux défis réside dans leur manque de compréhension réelle. Bien que ces systèmes puissent donner des réponses convaincantes, ils ne « comprennent » pas véritablement le sens des mots qu’ils utilisent. Leur apprentissage repose sur des algorithmes qui analysent et reproduisent des modèles linguistiques, ce qui les rend vulnérables à des erreurs lorsqu’ils sont confrontés à des contextes complexes ou ambiguës.

En outre, les IA modernes peinent à simuler des réactions émotionnelles authentiques et à interpréter les nuances sociales, deux aspects essentiels pour tromper un interlocuteur humain de manière convaincante. Les limites émotionnelles et contextuelles des IA trahissent souvent leur véritable nature de machines lorsqu’elles sont confrontées à des questions inattendues ou à des situations nouvelles.

Bien qu’elles soient capables de tenir des conversations avancées, ces IA sont encore loin de passer complètement le Test de Turing, qui nécessite une imitation plus subtile et humaine de la pensée et des émotions.

- Partager l'article :