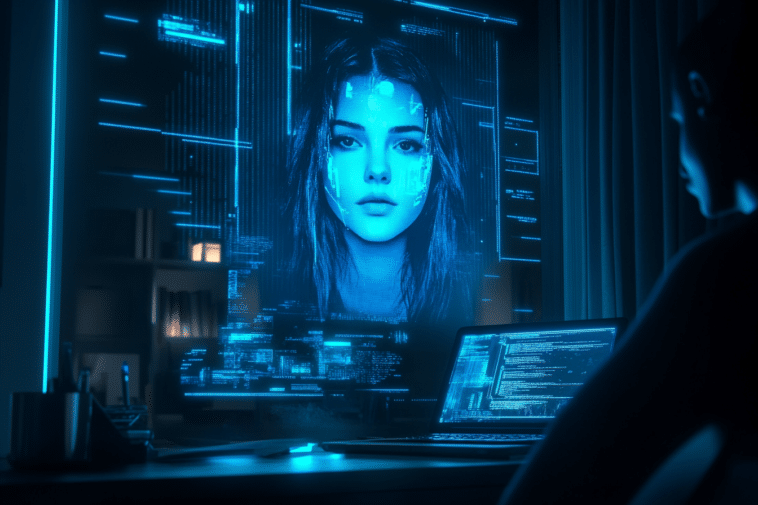

Découvrez quand l’IA dépasse les limites en créant un chatbot IA en se basant sur une femme assassinée, un scandale qui a fait écho dans l’univers du tech.

Est-ce que vous vous êtes imaginé un futur qui flirte dangereusement avec la dystopie ? Si ce n’est pas encore le cas, cette controverse ayant concerné Character.AI, une start-up spécialisée dans la création de chatbot IA, va vous faire frissonner ! Non seulement, la création de ce chatbot IA à partir d’une femme assassinée a secoué le monde tech mais aussi, elle a permis de soulever des questions éthiques. Si vous souhaitez en connaître davantage, je vous invite à poursuivre votre lecture et me dire ce que vous en pensez dans les commentaires.

Un chatbot basé sur une personne décédée, le cyclone qui a déferlé la toile

Pour que vous puissiez comprendre exactement le tenant et l’aboutissant de l’histoire, je vais vous mettre dans le contexte. Pour commencer, Character.AI est une société qui propose à ses clients la possibilité de créer leurs propres chatbots en fonction de leur besoin. Elle met donc à la disposition des utilisateurs des profils « virtuels » parmi lesquels ils peuvent faire leur choix.

Sauf que le problème s’est présenté lorsqu’un utilisateur avait créé son chatbot en se basant sur Jennifer Crecente, une jeune fille de 18 ans assassinée en 2006 par son ex-petit ami. Vous imaginez un peu le choc de sa famille en tombant nez-à-nez sur cette « résurrection virtuelle » 17 ans plus tard ?

Et comme vous pouvez le deviner, la famille n’a pas donné son autorisation. C’est donc tout à fait normal qu’elle s’est indignée devant l’utilisation de l’image de leur proche décédée et a dénoncée une exploitation technologique illicite.

Une découverte macabre qui a fait le tour des réseaux ?

Lorsque le père de la défunte, Drew Crecente, a reçu une alerte Google avec le nom Jennifer, ce dernier a pu découvrir que l’image de sa fille, assassinée quelques années auparavant, est désormais un avatar virtuel sur Character.AI. Il semblerait qu’elle, ou du moins, son image est maintenant exploitée pour apporter des conseils spécifiques sur le journalisme et les jeux vidéo.

Je vous laisse imaginer le choc que cela a produit auprès de cette famille dévastée par cette perte et cela dans une circonstance tragique. Et comme si cela n’était pas suffisant, près de 70 utilisateurs ont déjà interagi avec le chatbot IA de Jennifer.

L’histoire est par la suite devenue virale. L’ancien rédacteur en chef de Kotaku et oncle de la jeune fille, Brian Crecente, a dénoncé l’agissement de la start-up sur X. Cela a engendré une vague d’indignation sur la toile, poussant Character.AI a supprimé l’avatar de Jennifer Crecente de sa base de données. Cette dernière affirme que la création de ce chatbot qui s’est basé sur le profil d’une personne décédée violait les règles établies par l’entreprise sauf que le mal est déjà fait.

Un chatbot IA d’une femme assassinée, un cas qui n’est pas isolé ?

Character.AI se veut être innovant dans l’univers du chatbot IA face à des plateformes comme ChatGPT. Selon les chiffres, la start-up compte près de 20 millions d’utilisateurs actifs mensuels. Elle promet à ses utilisateurs de créer des personnages virtuels avec lesquels ils peuvent discuter.

Des célébrités comme Elon Musk jusqu’à des créations originales, chacun pourra y trouver son compte. En effet, Character.AI a aussi permis à ses utilisateurs de créer des bots sexuels explicites ou encore d’imiter des personnes réelles sans leur consentement.

On se demande donc jusqu’où cette start-up est prête à aller si nous nous référons à cette situation. Comment éviter que des individus ne crée des avatars à partir de personnes décédées, comme Jennifer, sans l’accord de leurs familles ? Est-ce qu’il est possible de recourir à la loi pour se protéger de ce genre d’exploitation ? Qu’est-ce qu’il faut faire dans ce genre de situation ?

Autant des questions sans réponse ! Toutefois, un véritable débat sur la question d’éthique autour de l’exploitation des chatbot IA est indispensable. Cela doit également s’étendre sur l’usage de l’IA dans son ensemble. Pourquoi me demanderez-vous ? Tout simplement lorsque des entreprises de tech utilisent des clauses d’arbitrage qui empêchent les utilisateurs de les poursuivre…

- Partager l'article :