Mercredi dernier, Figure, en partenariat avec OpenAI, a dévoilé Fugure 01, son robot humanoïde ayant la capacité d’engager une discussion en temps réel avec un humain.

Incroyable ! C’est ce qui décrit le mieux ce nouveau robot alimenté par GPT qui, en même temps, a la capacité de parler et de raisonner. Aujourd’hui, le PDG de Figure, Brett Adcock, est sorti de l’ombre. Il a donc réuni les acteurs de la technologie robotique. Notamment des experts de chez Boston Dynamics, d’Archer Aviation, de Google DeepMind et de Tesla. Son objectif : créer le tout premier robot à usage général pouvant répondre à l’utilisateur en temps réel.

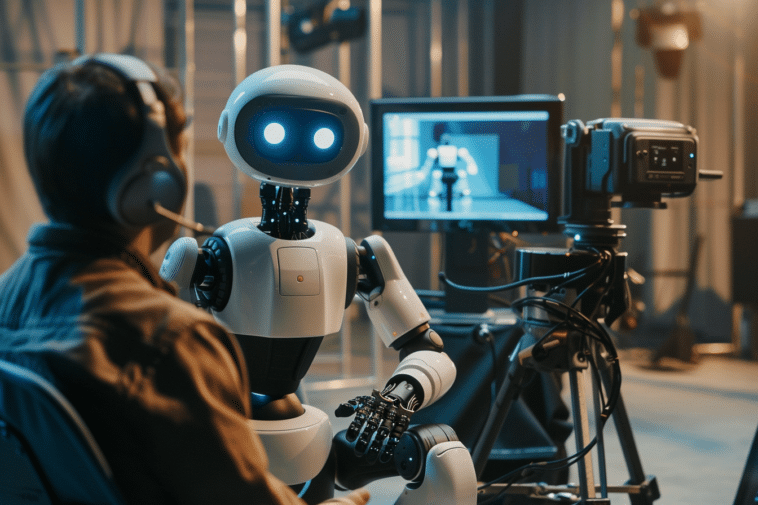

Un avant-goût de comment Figure 01 et OpenAI réinventent la robotique

Ces derniers mois, Figure a progressé à grande vitesse dans le développement de son robot humanoïde. Depuis le mois d’octobre dernier, le modèle dénommé Figure 01 était déjà opérationnel et capable d’accomplir des tâches autonomes de base.

À l’aube de la nouvelle année, les fonctionnalités du robot s’étaient considérablement étoffées avec l’ajout de capacités de surveillance et d’apprentissage. Ces avancées ont permis à Figure 01 d’être déployé en conditions réelles dès la mi-janvier au sein des installations de BMW.

Le mois dernier, nous avons eu l’opportunité d’observer le robot en action dans un entrepôt logistique. Peu après cette démonstration, Figure a annoncé avoir bouclé avec succès un tour de financement de série B ainsi qu’un partenariat stratégique avec OpenAI. L’objectif affiché est d’ailleurs de mettre au point conjointement des modèles d’intelligence artificielle nouvelle génération spécifiquement conçus pour les robots humanoïdes.

Un robot devient autonome en seulement deux semaines avec l’aide d’OpenAI

D’après les informations que Brett Adcock a partagées sur X, le robot humanoïde Figure 01 bénéficie désormais d’une collaboration étroite avec OpenAI dans le traitement des données visuelles et vocales.

Les caméras embarquées du robot transmettent en temps réel un flux vidéo à un puissant modèle de vision et de langage entraîné par OpenAI. Parallèlement, les réseaux neuronaux propriétaires de Figure analysent également les images captées à un rythme soutenu de 10 images par seconde.

OpenAI prend également en charge la capacité de compréhension vocale du robot, en interprétant les paroles prononcées. L’ensemble de ces informations multimodales est ensuite converti par l’intelligence artificielle de Figure en actions physiques précises, rapides et habiles.

Lors de la récente démonstration, Brett Adcock a confirmé que le robot opérait de manière pleinement autonome. Aucune télé-opération humaine n’a donc été nécessaire et les séquences filmées ont été tournées en temps réel.

Ce niveau de performance atteint en à peine deux semaines de partenariat avec OpenAI témoigne des avancées fulgurantes dans ce domaine. Brett Adcock ambitionne à terme de développer un modèle IA global. Ce qui devrait leur permettre de déployer de robots humanoïdes à grande échelle, de l’ordre du milliard d’unités. Un objectif qui pourrait bien être atteint rapidement au vu de la vitesse de progression de la société qui collabore activement avec OpenAI.

- Partager l'article :