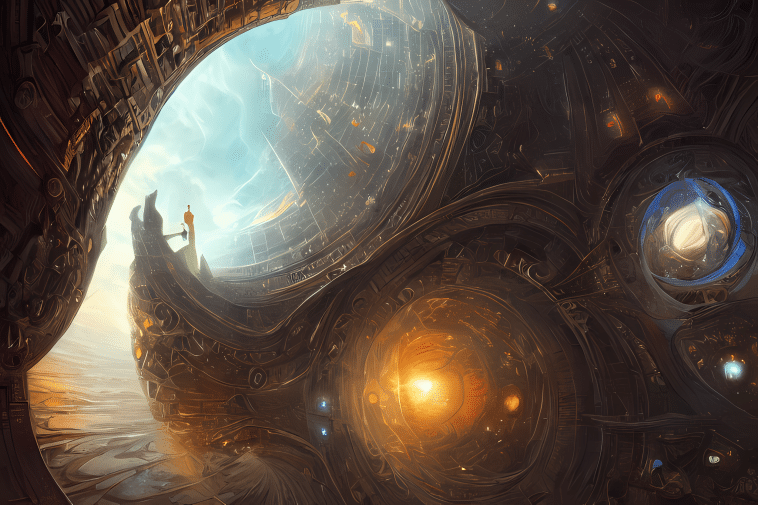

Initialement lancée avec un fort potentiel artistique, Stable Diffusion a rapidement captivé l’attention des utilisateurs par sa capacité à créer des visuels époustouflants à partir d’invites basiques. Explorez ses fonctionnalités, ses différences entre les versions, et apprenez à créer des images artistiques à partir d’invites simples;

Stable Diffusion se distingue par sa capacité à générer des images artistiques à partir d’invites simples, offrant une flexibilité et une créativité impressionnantes. Son modèle open source le rend accessible à un large public, permettant à chacun d’explorer ses fonctionnalités sans frais d’abonnement, contrairement à d’autres IA génératrices d’images comme Midjourney, qui propose un abonnement mensuel. La dernière version, Stable Diffusion 3, a amélioré la qualité des images et les capacités d’interaction avec des invites complexes, mais les avis des utilisateurs restent partagés entre les versions 1 et 2. Pour en avoir le cœur net, nous allons résumer l’essentiel sur cette IA de Stability AI.

Qui a créé Stable Diffusion ?

Trois acteurs sont responsables de la création et du développement de Stable Diffusion. Il s’agit de Stability AI, une start-up londonienne et porteur du projet, de Runway (développeur de système d’intelligence artificielle) et de l’Université de recherche publique LMU Munich.

Stable Diffusion 1 vs Stable Diffusion 2 : quelles différences ?

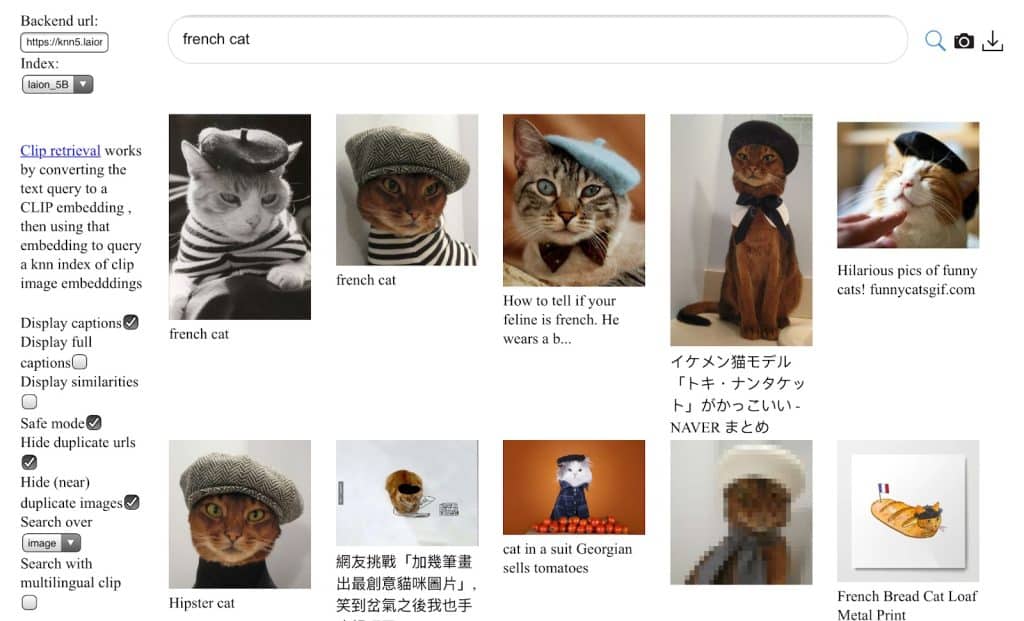

Ici, le but est de pouvoir identifier les vraies différences entre Stable Diffusion 1 et Stable Diffusion 2. La première dissemblance entre les deux versions relève de l’ouverture de CLIP. À titre d’information, CLIP signifie Contrastive Language-Image Pre-training. Il s’agit en d’autres termes d’un réseau neuronal dont la formation est basée sur un ensemble de textes et d’images (paires textes-images). Il peut également prendre en charge les instructions en langage naturel comme le cas de GPT-3.

CLIP pour Stable Diffusion 1 et openCLIP pour Stable Diffusion 2

Maintenant, revenons à nos moutons ! Stable Diffusion 1 utilise le CLIP d’OpenAI. C’est-à-dire un modèle d‘apprentissage automatique open source capable d’apprendre comment une légende peut décrire une image. Par contre, les flux de données qui ont servi à la formation de CLIP ne sont pas accessibles au grand public. Malgré le fait que le modèle soit lui-même open source.

En ce qui concerne Stable Diffusion 2, le système utilise OpenCLIP. C’est-à-dire une version open source de CLIP. La différence entre la formation de la version 1 et de la version 2 de Stable Diffusion c’est que la seconde bénéficie d’un flux de données de type LAION-5B. Autrement dit, un ensemble de données de très grande taille.

Selon Stability AI, le fait de recourir à OpenCLIP permet à Stable Diffusion 2 de générer des images de meilleure qualité. Et cela tout en apportant une supériorité au niveau des métriques.

Les impacts du passage de CLIP à OpenCLIp sur Stable Diffusion

Passer de CLIP à openCLIP a entraîné une divergence relative entre les deux versions de Stable Diffusion. On a d’ailleurs constaté une grande régression quant à la représentation des personnages publics et des illustrations artistiques sur Stable Diffusion 2. Même si les données servant à la formation de cette version ne font pas l’objet d’un filtrage pour la suppression des célébrités.

En réalité, ce sont les données de formation de CLIP, qui comptaient plus sur le côté artistique et les célébrités, qui font la différence entre les deux versions de Stable Diffusion. Entraînant par la suite une différence significative entre les résultats obtenus avec Stable Diffusion 1 et Stable Diffusion 2. D’autant plus que le public ne peut pas avoir accès aux données de CLIP. Ce qui fait qu’elles sont obsolètes et ne peuvent pas être utilisées pour l’apprentissage automatique de Stable Diffusion 2.

Quoi qu’il en soit, il existe quelques astuces pour obtenir de meilleurs résultats sur Stable Diffusion 2 malgré sa (soi-disant) faiblesse face à son prédécesseur.

Comment utiliser et générer des images avec Stable Diffusion ?

Comme toutes les autres IA génératrices d’images, Stable Diffusion utilise le script « text-to-image ». Il est donc indispensable de fournir des descriptions textuelles pour que le système puisse générer l’image souhaitée. En d’autres termes, on les appelle les « invites ». À cela s’ajoutent les nombreux paramètres servant de base pour chaque photo. Notamment la dimension, le type d’échantillonnage, ainsi que la valeur de départ.

Comment rédiger une bonne invite ?

Une bonne invite est le facteur clé d’une bonne image générée par l’intelligence artificielle. C’est d’ailleurs la base de toutes IA génératrices d’images. Alors, comment faire pour rédiger une bonne invite de texte ? Comment obtenir de meilleurs résultats en seulement quelques minutes ?

Des invites en anglais

La meilleure manière de rédiger une invite c’est de l’écrire en anglais. C’est important parce que les quelques 2 milliards de paires texte-images qui ont servi à la formation de Stable Diffusion sont en anglais. C’est presque la moitié de l’ensemble des paires image-texte sur lesquelles le système a été formé.

Apportez de la précision dans vos invites

En second lieu, soyez précis quand vous rédigez vos invites de texte. Pour obtenir un résultat plus esthétique, n’hésitez pas à détailler vos descriptions. Et rappelez-vous que les mots du début des invites sont plus importants que ceux de la fin.

N’oubliez pas de préciser le type d’imagerie que vous souhaitez obtenir

Stable Diffusion est capable de générer des images de type peintures, dessins animés, GIF, photographie, etc. Il est donc important de préciser le type d’imagerie que vous souhaitez obtenir pour que le système génère l’image correspondante.

Les mentions « tendance sur arstation » et « moteur irréel »

Ces deux mentions permettent aux utilisateurs d’apporter plus de style et de rendre les images à générer plus artistiques. Il s’agit ici de jouer avec des mots tout en ajoutant des adjectifs ou des propriétés techniques à vos invites. On peut par exemple inclure les mots magnifique, beau, génial, mise au point nette, éclairage dramatique, ou encore jeux de couleurs triadiques.

Comment ajuster les images

Pour obtenir un résultat de meilleure qualité, Stable Diffusion est doté d’une fonctionnalité d’ajustement d’images. À titre d’information, toutes les vignettes générées par le système sont générées dans DreamStudio. Ce qui rend possible la modification et la recréation des anciennes images. Cela dit, chaque invite peut être réutilisée dans le but de créer des images plus ou moins similaires aux versions précédentes.

Création des GIF avec Stable Diffusion

Petit à petit, après sa sortie, Stable Diffusion est devenu l’outil incontournable des créateurs d’arts visuels. Il permet d’ailleurs de créer des animations, ce que l’on appelle généralement les GIF.

Il s’agit ici de la création d’animations à partir d’une entrée vidéo initiale et en utilisant des tenseurs de bruits en tant qu’entrée. Sinon, vous pouvez également recourir à une vidéo existante en tant que base pour l’animation. Cette transformation est rendue possible grâce à la capacité de Stable Diffusion à prendre en charge la traduction « image-to-image ». Voici comment ça fonctionne !

Le flux de travail « image-to-image » va avant tout encoder une image initiale en code latent. Ensuite, un bruit va être ajouté à ce code et sera utilisé en tant que tenseur de bruit d’entrée. En même temps, le système va exécuter le processus de diffusion qui sera modifié, mais très légèrement. On parle ici de l’introduction d’un nouveau paramètre appelé « Force ».

C’est ce dernier qui va prendre le contrôle de la quantité de contenu de l’image d’origine. Mais celle-ci sera préservée tout au long du processus, avec une valeur qui varie entre 0,0 et 1,0. Le processus va se répéter et le nombre d’étapes qu’il va suivre va dépendre en grande partie du planificateur. Autrement dit, les utilisateurs peuvent à tout moment, dans le processus, supprimer le tenseur de bruit.

DreamStudio bêta : prix d’accès

Stable Diffusion est gratuit, certes, parce qu’il est open source, mais l’accès à DreamStudio est payant en partie. Bien que les nouveaux utilisateurs puissent gagner gratuitement 100 crédits, pour continuer à utiliser la plateforme, les utilisateurs peuvent acheter des crédits supplémentaires. Le coût est de 10 $ pour 1 000 crédits, ce qui est suffisant pour générer environ 5 000 images en fonction des réglages choisis, tels que la résolution et la complexité de l’image.

Configuration requise

Dans le cas où ça vous intéresserait d’expérimenter Stable Diffusion sur votre propre appareil, le système exige au moins 10 Go de VRAM. C’est le minimum requis pour pouvoir générer une image d’une dimension de 512 x 512 px.

Stability AI recommande également l’utilisation des puces NVIDIA si vous voulez vraiment exécuter le modèle sur votre propre ordinateur. Et d’après la société, ils vont optimiser la version actuelle pour une utilisation sur les puces AMD, sur M1 et M2 de MacBook, et sur les autres chipsets.

Stability AI annonce la version bêta de Stable Diffusion XL pour API et DreamStudio

La société Stability AI a annoncé la sortie en version bêta de Stable Diffusion XL (SDXL). Il s’agit de son dernier modèle de génération d’images qui, selon un communiqué de presse, a été conçu pour les entreprises et qui « excelle dans le photoréalisme ».

Selon Tom Mason, directeur technique de Stability AI « SDXL apporte une richesse à la génération d’images qui transforme plusieurs secteurs. Notamment la conception graphique et l’architecture ». La version bêta de SDXL est disponible dans l’API de Stability et dans la suite de programmation DreamStudio, qui s’adressent aux développeurs d’entreprise.

Selon la société, SDXL produit une imagerie et une composition plus détaillées que son prédécesseur Stable Diffusion 2.1. Cela inclut un photoréalisme de niveau supérieur, une composition d’image et une génération de visage améliorées et une plus grande capacité à produire un texte lisible.

SDXL va également au-delà de l’incitation texte-image pour inclure:

- l’incitation image-image (saisie d’une image pour obtenir des variations de cette image),

- l’inpainting (reconstitution des parties manquantes d’une image)

- et l’outpainting (construction d’une extension transparente d’une image existante).

Le vice-président de l’ingénierie chez Stability AI a ajouté que si le modèle SDXL constitue une amélioration par rapport à l’architecture du modèle 2.0, les modèles 3.0 sont encore en cours de développement.

Stable Diffusion 3

Stability AI continue d’innover avec le lancement de Stable Diffusion 3, une avancée majeure dans la génération d’images par IA. Le nouveau modèle utilise une architecture appelée Multimodal Diffusion Transformer (MMDiT), qui améliore la compréhension du texte et la génération d’images de haute qualité. Stable Diffusion 3 surpasse les systèmes actuels comme DALL·E 3 et Midjourney v6 en termes de fidélité visuelle, de respect des invites et de qualité typographique, selon des évaluations basées sur les préférences des utilisateurs.

La série Stable Diffusion 3 inclut plusieurs variantes, de 800 millions à 8 milliards de paramètres, permettant de répondre à différents besoins matériels. Cela signifie que même avec un matériel grand public, il est possible de générer des images photoréalistes et de haute qualité en 34 secondes avec une carte graphique RTX 4090.

En plus des fonctionnalités standard de génération d’images à partir de texte, la nouvelle version inclut des options avancées telles que l’outpainting (extension d’image), l’inpainting (reconstruction d’images) et la génération d’images à partir d’une image de départ. Pour les entreprises et les développeurs, Stability AI propose une intégration via son API et des solutions optimisées pour les GPU NVIDIA et AMD.

Enfin, Stability AI a introduit Stable Diffusion Reimagine, un outil permettant de créer des variations infinies d’une image existante sans complexité d’invite, facilitant ainsi la créativité des utilisateurs.

Notes d’adieu

Stable Diffusion se différencie des autres IA génératrices d’images en raison de sa gratuité, étant donné qu’il est open source. Il y a donc une grande accessibilité pour que les utilisateurs puissent apporter leur contribution. Le second trait caractéristique de Stable Diffusion c’est le fait qu’il est possible de l’exécuter sur un matériel grand public. Ce qui n’est pas le cas pour les autres modèles d’apprentissage automatique tels que DALL-E ou Midjourney.

- Partager l'article :