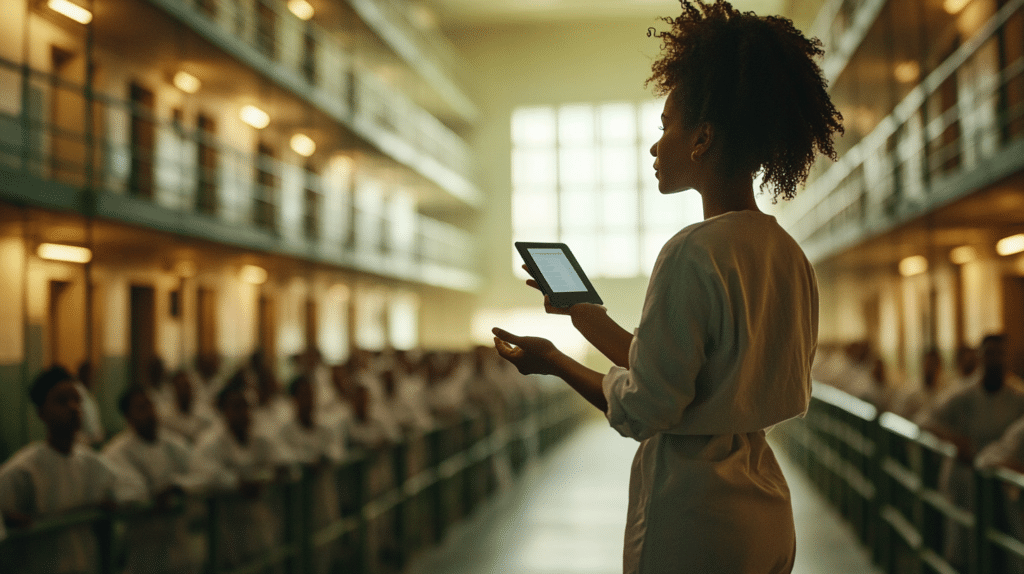

Un chatbot d’intelligence artificielle (IA), utilisé dans une formation psychosociale, a accidentellement révélé le nom d’une victime présumée de harcèlement sexuel. Cet incident, survenu à la prison de Bunbury en Australie-Occidentale, soulève des interrogations sur les risques éthiques liés à l’utilisation des IA dans des contextes sensibles.

Un nom révélé par erreur pendant une formation

L’entreprise, responsable de la formation en sécurité psychosociale, a utilisé l’IA pour générer des scénarios supposément fictifs lors d’une session à la prison de Bunbury. Cependant, Charlotte Ingham, formatrice, a constaté que l’IA avait inséré le nom réel d’une ancienne employée dans une étude de cas. Ce nom était celui de Bronwyn Hendry, une victime présumée de harcèlement sexuel.

Lorsque Mme Ingham a présenté la diapositive, un membre de la salle a immédiatement relevé que le scénario n’était pas une fiction. Celle-ci est actuellement au cœur d’une affaire devant la Cour fédérale australienne, où elle accuse des supérieurs de harcèlement sexuel et d’intimidation. Cette découverte a surpris la formatrice. Elle ne pensait pas que le chatbot pourrait inclure des noms réels dans ses réponses.

Le ministère de la justice désengagé

Le ministère de la Justice a commandé cette formation. De ce fait il a précisé qu’il n’avait pas examiné les supports utilisés. Toutefois, le ministère, vivement mécontent de cet incident, s’est engagé à ce qu’une telle situation ne se reproduise plus dans ses futurs programmes de formation. Mme Hendry, quant à elle, considère que cette réaction est tardive et insuffisante. Selon elle, le ministère aurait dû anticiper et prévenir ce type d’erreur.

Cet incident soulève également des préoccupations plus larges sur l’utilisation des IA dans des environnements professionnels. La professeure Jeannie Paterson, experte en éthique numérique, avertit que les entreprises doivent faire preuve d’une extrême prudence. Elle met en garde contre les risques liés aux chatbots IA, notamment les harcèlements sexuels, car ces outils peuvent générer des contenus sensibles.

Elle explique également que l’IA pourrait régurgiter des informations réelles, même lorsque le résultat est censé être fictif. Ce comportement inattendu soulève d’importantes questions éthiques. Les entreprises doivent veiller à ce que les outils qu’elles utilisent n’entraînent ni confusion ni préjudice.

La professeure Paterson recommande aux entreprises de ne pas interdire l’utilisation de l’IA. Cependant, elle conseille d’encadrer son utilisation pour minimiser les risques. En particulier, elle suggère de vérifier les informations sensibles avant de les soumettre à un chatbot. Il est crucial de rester vigilant face à la possibilité que l’IA génère des erreurs involontaires.

Une situation inconfortable pour la victime

Mme Hendry lutte actuellement pour faire valoir ses droits devant la Cour fédérale. Elle exprime son mécontentement. L’utilisation de ses expériences personnelles dans cette formation aggrave son sentiment d’injustice. En outre, elle souligne que cet incident ajoute une pression supplémentaire.

En réalité, cela renforce son combat pour se faire entendre dans un contexte déjà difficile. La victime présumée appelle à une plus grande transparence et à une meilleure supervision des formations commandées par des institutions publiques.

Les leçons à tirer de cet incident

L’utilisation croissante des IA dans des contextes professionnels nécessite une surveillance accrue. Cet incident montre les dangers potentiels de s’appuyer trop largement sur des technologies qui ne sont pas encore totalement fiables. Ces risques sont particulièrement élevés lorsqu’il s’agit de traiter des informations sensibles.

Suite à cet incident, le ministère de la Justice et les entreprises doivent repenser leurs stratégies et définir un cadre réglementaire strict pour limiter les risques liés à l’utilisation de l’IA. L’affaire de la prison de Bunbury rappelle que les institutions doivent prendre des mesures proactives pour protéger les droits des individus tout en utilisant ces technologies émergentes. Des régulations et politiques renforcées seront probablement nécessaires pour éviter de nouvelles erreurs graves.

- Partager l'article :