L’eXplainable AI est un élément essentiel dans la mise en place d’une l’intelligence artificielle responsable. Cela signifie que les utilisateurs finaux peuvent comprendre le chemin suivi par un système lors d’une prise de décision.

L’intelligence artificielle est aujourd’hui au cœur de toute nouvelle technologie. Touchant presque tous les domaines, tout le monde en parle, mais pas toujours en bien. L’eXpainable AI vise à permettre aux humains de comprendre comment les machines prennent leur décision. En d’autres termes, ce processus est nécessaire pour attirer la confiance des utilisateurs.

En quoi consiste l’eXplainable AI ?

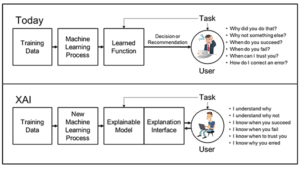

Force est de reconnaître que l’intelligence artificielle présente plusieurs avantages pour notre vie quotidienne et pour les entreprises. Elle impacte l’éducation, l’industrie de la santé, la défense, etc. Le machine learning et le deep learning montrent des capacités prédictive et décisionnelle impressionnantes. Mais comment tout cela est-il possible ? En réalité, ces systèmes prennent des décisions qui changent nos vies, mais nous ne savons pas pourquoi ni comment ils arrivent à ces résultats.

L’eXplainable AI, aussi connu sous l’acronyme XAI, vise à répondre à ces questions. Pour faire simple, le concept fait référence à une IA explicable que les humains peuvent comprendre.

Comment définir l’XAI ?

L’eXplainable AI peut se traduire par l’explicabilité de l’intelligence artificielle. Elle explique par le biais de graphiques dynamiques ou de descriptions textuelles les processus de prise de décision. En d’autres termes, l’IA explicable se doit d’être un service transparent et construit de manière à ce que les utilisateurs puissent remonter à l’origine de chaque décision. L’objectif de l’XAI est de faire en sorte que les humains comprennent et fassent confiance aux résultats.

L’importance de l’eXplainable AI

Pour certaines fonctionnalités, comme la prédiction de texte automatique ou les chatbots, le concept d’eXplanaible AI ne semble pas important. Mais quand il s’agit des systèmes ayant des impacts à grande échelle, les utilisateurs finaux ont besoin de comprendre. C’est par exemple le cas pour les applications militaires ou les dispositifs médicaux.

Les algorithmes ML et DL ont la capacité d’extraire des informations et de les analyser de manière complexe à partir de grandes quantités de données. Les résultats visent avant tout à aider les humains à être plus productifs et à prendre de meilleures décisions. Maintenant, s’ils n’ont aucune idée de la raison pour laquelle les systèmes suggèrent ces décisions, ils ne feront pas confiance à ces résultats.

Par ailleurs, il s’est avéré dans plusieurs cas que les algorithmes d’IA peuvent être biaisés, affectant ainsi plusieurs personnes. Ainsi, la confiance des utilisateurs repose également sur la transparence des modèles pour révéler et écarter les éventuels biais.

En outre, l’eXplainable AI peut aider pour l’audit. Même les systèmes les plus avancés peuvent rencontrer des erreurs ou des dysfonctionnements. Des données obsolètes ou biaisées peuvent conduire à des résultats inexacts. L’IA explicable offre la possibilité de retracer le chemin parcouru par le système et d’identifier ainsi la source des problèmes. Et en quelque sorte, l’XAI permet d’optimiser l’utilisation de l’IA dans une organisation.

De plus, la transparence, la confiance et l’applicabilité sont des éléments clés dans la mise en place d’une IA responsable au sein d’une entreprise.

Comment faut-il s’y prendre ?

Avant toute chose, le plus important est de tenir compte de toutes les parties et de leurs attentes en matière d’explicabilité. Cela implique à la fois les consommateurs, les chefs d’entreprises et les régulateurs. Le premier point à éclaircir concerne leur niveau de compréhension de l’IA. De même, leur point de vue sur l’IA est un élément à prendre en compte, ainsi que leurs aptitudes à recevoir les informations. Ces questions permettent de constituer une base sur laquelle fonder l’XAI.

Une approche consiste à créer une suite de techniques de machine learning suivant deux objectifs. La première vise à produire des modèles d’IA plus explicables avec un haut niveau de performance (précision et prédiction). Le deuxième objectif est de permettre aux utilisateurs finaux de comprendre et de faire confiance à ces systèmes afin de les gérer efficacement.

Entre autres, les nouveaux systèmes d’apprentissage seront capables de s’expliquer et d’identifier leurs forces et leurs faiblesses. Ils devront également avoir la capacité de faire comprendre leurs futures décisions. À cette fin, l’eXplainable AI combine les modèles avec des interfaces homme-machine de pointe. Cela permettra de traduire les modèles dans un langage compréhensible et utile pour les humains.

- Partager l'article :