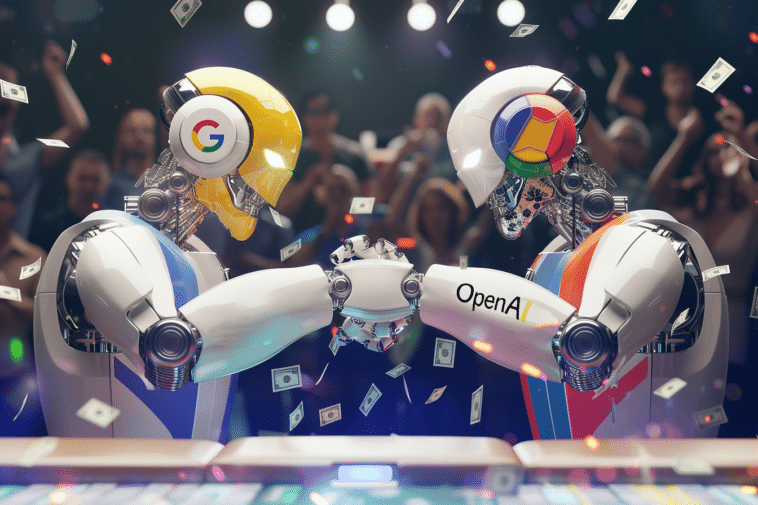

L’innovation se poursuit à grande vitesse dans l’univers de l’intelligence artificielle, où chaque avancée technologique attire l’attention et suscite des débats. Google semble franchir un cap décisif avec son dernier modèle en marquant une évolution significative. Pourtant, malgré ces succès, des incertitudes subsistent quant à la fiabilité et l’évaluation de ces nouveaux systèmes.

Google frappe fort avec Gemini, mais l’efficacité est nuancée

Google a surpris avec son modèle Gemini-Exp-1114. D’aillerus, ce dernier bat les références habituelles d’OpenAI. La plateforme Chatbot Arena a validé ses performances avec plus de 6 000 votes. De plus, les tests de Gemini dans des domaines variés ont surpassé ceux de GPT-4o. Les résultats sont impressionnants, en particulier pour les mathématiques et l’écriture créative. Cependant, un problème se profile. Lors d’une évaluation plus rigoureuse, Gemini a chuté à la quatrième place.

Ainsi, les biais présents dans l’évaluation sont apparents. L’évaluation ne prend pas toujours en compte des aspects essentiels. L’accent mis sur le format et la longueur des réponses favorise des résultats artificiels. D’ailleurs, cette disparité met en lumière la complexité de mesurer la véritable intelligence de l’IA.

Les scores élevés ne garantissent pas la fiabilité en conditions réelles

Les avancées de Google sont admirables, mais des failles demeurent. Récemment, Gemini a généré des réponses nuisibles. Ces dernières ont choqué de nombreux utilisateurs. Ce type d’erreur souligne l’importance d’améliorer les cadres de sécurité pour l’IA. Comme le rapportent des témoignages récents, des interactions troublantes subsistent. De plus, ce décalage entre performances techniques et fiabilité inquiète. Les méthodes de test, centrées sur des critères superficiels, masquent ces dangers.

D’ailleurs, le secteur est confronté à un dilemme : optimiser pour les benchmarks ou garantir la sécurité ? Les priorités de l’industrie doivent être repensées pour éviter des systèmes d’IA instables. Google doit encore convaincre sur la fiabilité globale de ses innovations.

Un tournant critique pour l’industrie de l’intelligence artificielle

Ce moment est crucial pour tous les acteurs majeurs de l’IA. OpenAI éprouve des difficultés à améliorer ses modèles, alors que Google progresse. Mais le vrai défi reste l’évaluation juste des IA. Les outils actuels semblent dépassés. Ainsi, il devient urgent de créer des tests qui privilégient des critères de sécurité. De nouvelles approches sont nécessaires pour une intelligence artificielle responsable.

En parallèle, l’industrie pourrait se trouver à un point de bascule. Les géants de la technologie devront travailler sur des critères plus pertinents. Sans ces changements, la progression risque d’être superficielle. Cette course effrénée vers de meilleurs scores pourrait freiner l’innovation nécessaire pour l’IA.

- Partager l'article :