L’algorithme PaLM de Google AI est un modèle de langage révolutionnaire développé dans le cadre du projet Pathways.

Le géant du numérique a pour objectif de développer une IA à usage général. Les grands modèles de langage (LLM) font partie de ces solutions qui permettent d’effectuer plus d’une tâche. Google ajoute un nouveau modèle dans son portefeuille et l’a baptisé Pathways Language Model (PaLM).

Google AI présente PaLM

L’année dernière, Google a présenté une architecture d’IA appelée Pathways. Le projet consiste à développer une IA polyvalente qui permettrait de résoudre tous les problèmes. Les pratiques courantes impliquent de former plusieurs algorithmes pour effectuer des tâches spécifiques. Au lieu de cela, Pathways se présente comme un modèle unique capable d’effectuer des milliers de tâches différentes.

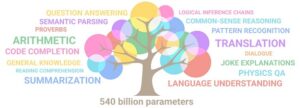

Les chercheurs de Google AI ont récemment publié un article intitulé PaLM : Scaling Language Modeling with Pathways. Il s’agit d’une présentation de PaLM (Pathways Language Model), un modèle Transformer à 540 milliards de paramètres.

Une IA révolutionnaire

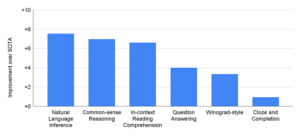

PaLM s’est entraîné sur un ensemble de données linguistiques incluant documents web, livres, conversations et code. Il a ensuite été évalué sur des centaines de tâches de NLP du BIG-bench. Dans de nombreux cas, le modèle a dépassé les autres modèles de langage dont GPT-3, le Megatron-Turing NLG, Gopher et bien d’autres.

Les chercheurs de Google ont utilisé une approche dite « few-shot learning » pour former PaLM. Selon eux, il s’agit d’une technique qui se rapproche plus de la manière dont les humains apprennent, comparée au deep learning.

Concernant ses performances, elle a surpassé les plus grands modèles dans 28 tâches (sur 29) de compréhension et de génération du langage. Par ailleurs, PaLM a également affiché des capacités remarquables dans la résolution de tâches de raisonnement arithmétique et de bon sens.

Il peut même fournir des explications en combinant le raisonnement logique, la connaissance du monde et la compréhension de la langue. Les chercheurs ont démontré cela en lui demandant d’expliquer des blagues qu’il n’avait jamais vues auparavant. En termes de codage, sa performance égale celle du modèle Codex avec un entraînement sur 50 fois moins de code Python.

Une étude récente a mis l’accent sur les dangers liés aux grands modèles de langage. En réponse à cela, les chercheurs de Google ont inclus dans l’article une documentation sur les considérations éthiques.

- Partager l'article :