La boîte à outils oneAPI AI Analytics d’Intel fournit des frameworks Python pour accélérer les pipelines de data science et de machine learning.

Le machine learning ou l’apprentissage automatique repose sur des milliers d’itérations sur les échantillons de données pour optimiser les modèles. Cela requiert une grande consommation d’énergie et des traitements laborieux. Les accélérateurs logiciels d’IA sont apparus comme une méthode d’optimisation capable de surpasser le temps d’exécution et la consommation d’énergie du code traditionnel.

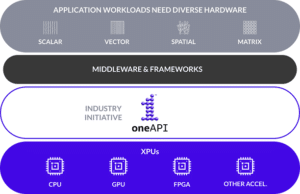

La programmation unifiée par Intel

Intel a lancé la plateforme de programmation unifiée appelée oneAPI. Elle fournit des outils pour différentes applications notamment de calcul de haute performance, d’IA, d’IoT et de ray tracing. oneAPI cible une variété d’architectures telles que les CPU, les GPU, les FPGA et d’autres accélérateurs.

La boîte à outils oneAPI AI Analytics fournit des outils et frameworks Python permettant d’accélérer les pipelines de data science et de machine learning sur les architectures Intel. Ce kit permet également d’optimiser le deep learning grâce aux frameworks tels que TensorFlow et PyTorch.

Accélérer le machine learning avec oneAPI d’Intel

Pour l’apprentissage automatique, le kit comprend des frameworks optimisés pour Scikit-learn, Modin et XGBoost. Les deux premières distributions permettent de gagner 10 à 100 fois plus de vitesse. De ce fait, elles améliorent la précision et la performance des modèles ML.

Notons que Scikit-learn est le cadre le plus utilisé pour former des modèles basés sur la régression linéaire, la régression logistique, les arbres de décision ou le random forest. Le framework oneAPI d’Intel offre la possibilité d’effectuer un machine learning distribué à l’échelle des clusters.

Quant à la distribution en Modin, elle permet de mettre à l’échelle et d’accélérer les flux de travail pandas sur les des DataFrames multinœuds. Pour cela, il suffit de modifier une seule ligne de code. Modin est également livré avec une interface SQL et des blocs-notes Jupyter.

Pour Python, le kit fournit de meilleures performances grâce à l’accélération des principaux paquets numériques et scientifiques. Cela inclut le compilateur Numba et l’exécution multicœur pour les CPU modernes. Enfin, le DPPy (Data Parallel Python) permet de programmer plusieurs dispositifs avec le même modèle sans réécrire le code.

- Partager l'article :