L’évolution de l’intelligence artificielle dans le domaine militaire inquiète de nombreux experts en sécurité. Alex Stamos, spécialiste en cybersécurité, avertit des dangers de laisser l’IA prendre le contrôle des décisions létales.

Lors du Forum de Paris sur la paix, organisé les 11 et 12 novembre, les débats sur l’IA se sont déroulés dans un contexte tendu. Les conflits en Europe et au Moyen-Orient révèlent l’usage croissant de technologies avancées. Les chaînes Telegram regorgent de vidéos de drones. Ces derniers traquent des cibles avant d’effectuer des frappes. D’ailleurs, Israël aurait utilisé des systèmes d’IA pour choisir des cibles à Gaza.

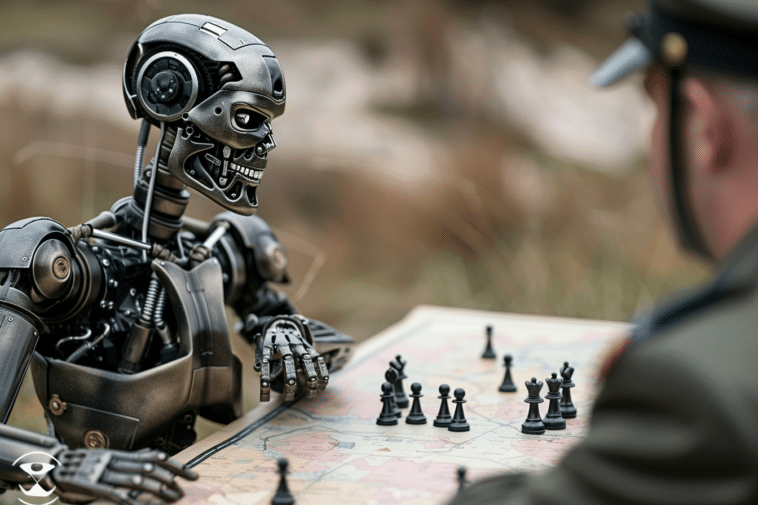

Une guerre menée par l’IA, un cauchemar imminent

Nous sommes à un tournant décisif de l’histoire militaire. La guerre pourrait passer d’opérations humaines assistées par l’IA à des opérations entièrement dirigées par l’IA, avec un appui humain minimal. Imaginez des machines autonomes prenant des décisions de vie ou de mort. Cette perspective soulève des craintes sur la possibilité de crimes de guerre impensables.

Les systèmes d’IA offrent une efficacité redoutable. Cependant, retirer l’humain du processus décisionnel supprime la capacité de remettre en question les ordres. Ainsi, les massacres de civils ou les exécutions de combattants désarmés pourraient devenir des réalités plus fréquentes. Le droit international serait sérieusement menacé, sans personnes pour freiner les actions des machines.

Des risques de pertes humaines massives

Les systèmes d’IA évoluent rapidement en rendant la situation encore plus dangereuse. Une simple erreur de programmation pourrait entraîner des pertes humaines massives. De plus, une défaillance non détectée pourrait pousser des conflits mineurs vers des escalades incontrôlées. Ces erreurs se produiraient avant même que des superviseurs humains puissent les corriger.

Les risques de l’IA ne se limitent pas aux champs de bataille. Les cyberarmes autonomes représentent une menace grandissante. Des États utilisent déjà des malwares automatisés pour des cyberattaques destructrices. Par exemple, le virus Stuxnet, développé par les États-Unis, a paralysé le programme nucléaire iranien. Mais ces outils nécessitaient des renseignements humains détaillés pour atteindre leur cible.

Des cyberattaques qui deviennent incontrôlables

Les virus autonomes comme Stuxnet montrent la complexité des cyberattaques modernes. D’ailleurs, les cyberarmes comme NotPetya et WannaCry, déployées par la Russie et la Corée du Nord, ont eu des effets dévastateurs. Ces attaques se sont répandues de manière incontrôlable. Ces dernières ont d’ailleurs provoqué des dégâts économiques énormes dans le monde entier.

Stamos appelle la France à prendre le leadership face à ces menaces. Il insiste sur la nécessité d’encadrer l’utilisation militaire de l’IA. Les armes autonomes pourraient redéfinir le rapport de force entre nations. Cela crée ainsi une course à l’armement incontrôlable. Il reste à voir si les dirigeants politiques répondront à cet appel et prendront des mesures concrètes.

- Partager l'article :